Datos definitivos de la gama X1 (ojo 56k)

-

Se nota que hoy en dia esta empezando a primar mas las funcionalidades que sea capaz de ofrecer la targeta y no la potencia bruta. A pesar de contar con solo 16 pipes frente a los 24 de la 7800GTX, parece que ATI ha intentado mejorar la calidad de la imagen y la aplicacion de filtros. En mi opinion es una muy buena idea, veremos como les responde el mercado.

Sabes de resultados reales en comparacion con la serie 7 de nVidia??? Esos resultados en el 3DMark2005 me parecen demasiado buenos como para que sean ciertos. Si es tan buena como parecen indicar estas tablas, el crossfire hara que la lucha con nVidia sea terrible

-

Resultados reales, el miércoles, que es cuando se levanta el acuerdo de confidencialidad. Sobre el resultado del 3DMark, no te equivoques, esos 9100 puntos parece que son a la baja (se rumorea con los 9700, debido a que los 9100 habrían sido con velocidades inferiores, 600/1400 en vez de 625/1500) pero no te fies del 3DMark05, es un test que provoca cuellos de botella en partes de las gráficas que no lo son en ningún juego. Tiene una limitación debida a un exceso de geometría bestial en los vertex shaders, por lo que ATI suele tener mejores puntuaciones en este test debido a su mayor potencia de vertex shaders.

Una característica que me parece que va a ser fundamental es la posibilidad de utilizar el formato 10:10:10:2 (RGBA) para el backbuffer, con blending y antialiasing, que es el mismo formato que va a utilizar la XBox360 para realizar el HDR+AA. Vamos a ver esta característica aprovechada en muchos más juegos que hasta ahora, al menos todos los que también salgan para XBox360, y por las características de este topo de datos, no consume más ancho de banda de memoria que el formato Int8. Un gran punto a favor para conseguir un rendimiento aceptable con HDR+AA, y estas características son para toda la gama X1, incluida la X1300.

Me parece que nVidia tiene ahora las de perder, no tanto como con la gama FX, pero vamos a empezar a ver bajadas de precio brutales. Ya se están empezando a ver en Taiwan 7800GT por 210$, así que es posible que pronto las veamos por aquí por unos 300€ o incluso menos… Bendita competencia

-

Si la 7800GT baja a 300 Euros me da a mi que la gente la comprará si ve que la X1800XT esta por 500 euros (por ej.)..

-

Esa es la idea, como pasó con las 5900XT que tan buen precio tenían.

-

¡Esta publicación está eliminada! -

A ver como va.. Pero la calidad visual que ofrecen las ATI siempre ha sido superior, y ahora mucho más, a ver como afecta esto (para mi me parece muy bien que pulan la calidad visual, al fin y al cabo es de lo que disfrutamos..)

-

Lo de que nVidia tiene las de perder…........no estaria yo muy seguro ya que tiene grandes y poderosos aliados (IBM sin ir mas lejos les fabrica sus cores).

Que ATI se vuelque con la Xbox360 es en cierto modo normal ya que nVidida hace lo mismo con Sony en el desarrollo del Cell para la Play3.

-

Ojalá ATI le plante cara de verdad a nVidia y le saque los colores, tal y como está haciendo ahora mismo nVidia a ATI con su 7800GTX sin competencia desde hace meses, porque nos ibamos a beneficiar la de dios los consumidores. Pero no sólo me parece exagerado la tabla a la que hace referencia Kynes, sino que diría que es justo al revés, y ATI a duras penas va a rascar bola en esta generación.

Lo digo viendo por ejemplo esta review, en que como no fueron invitados oficialmente por ATI, no tenían acuerdos de confidencialidad por el medio. O los artículos de The Inquirer (vaaaale!! las noticias de este sitio hay que cogerlas con cuidado ;)), en que hablaban de que nVidia había cancelado la 7800 Ultra en cuanto recibió las primeras filtraciones de rendimiento de las nuevas ATI, sencillamente porque vieron que no necesitaban pisar el acelerador y que podían centrarse en otras cosas.

Por no hablar del Crossfire, que si echais un vistazo por ejemplo a este artículo de Xbitlabs (fijaros que también aparece la 6800 Ultra, luego no digais que comparan 850XT con 7800GTX solamente), parece clarísimo que es incluso más petardo que el SLI de nVidia (vamos, que la subida de rendimiento muchas veces es ridícula, y eso cuando funciona).Como ya dije, que conste que me encantaría que ATI contraatacara ahora con fuerza, y los precios de las nVidia por los suelos, luego al revés…y así sucesivamente. Pero de momento no me transmite buenas vibraciones la información escasísima que va apareciendo. Además, me apetecía hacer un poco de abogado del diablo de nVidia para daros pie a continuar el debate

-

Lo de que nVidia tiene las de perder…........no estaria yo muy seguro ya que tiene grandes y poderosos aliados (IBM sin ir mas lejos les fabrica sus cores).

Que ATI se vuelque con la Xbox360 es en cierto modo normal ya que nVidida hace lo mismo con Sony en el desarrollo del Cell para la Play3.

IBM le fabricaba sus cores, las 6800, pero ya no. Ahora trabajan con TSMC y UMC (principalmente con la primera en el caso de las gráficas) No estoy diciendo que nVidia tenga las de perder en el sentido de un cataclismo financiero ni nada por el estilo, me refiero a que tiene las de perder en cuanto a las capacidades de cada tarjeta. No me refiero a la potencia, en la que probablemente estén muy igualadas, me refiero a que no solo venden tarjetas los frames por segundo, los que se gastan 500€ en una tarjeta también le suelen dar importancia a la calidad visual, y la comparación G70 con R520 no pinta muy bien que digamos para nVidia (por lo que se puede deducir de estas diapositivas, claro)

El apoyo de Sony a nVidia no es tal, y voy a intentar explicarme. En un principio Sony quería utilizar dos chips cell en cada Play3, uno destinado a hacer principalmente de procesador, y el otro para los gráficos (cuando digo principalmente es porque la idea era que las cargas se balanceasen para destinar recursos a una característica u otra en función de las necesidades) Como Cell no ha resultado un buen chip para gráficos, Sony ha tenido que llegar a un acuerdo con nVidia para que les fabricase un chip. El RSX es el chip que nVidia va a destinar para la play3, y se rumorea que va a ser muy parecido al G70, pero sin unidades de vértices (puede utilizar parte del cell para calcular las transformaciones geométricas) y con bus de 128 bits. Todavía no está claro si se va a aumentar el número de unidades de texturas y de píxeles respecto al G70, al menos en el caso de las unidades de texturas no tendría mucho sentido ya que con un bus de 128 bits tienes un gran cuello de botella en el ancho de banda para llenar esas unidades de texturas, y el chip será fabricado en 90nm. Vamos, un copypaste del chip de las 7800, lo que no requiere mucho trabajo, pero tampoco implica una gran inversión. El fabricar el RSX no va a suponer una gran innovación tecnológica en el caso de nVidia, por lo que no le beneficia a nivel de futuros chips. Esto no es el caso de ATI con la XBox360 y Xenos, ya que es un chip muy parecido a lo que deben ser los chips compatibles con la versión futura de DirectX. Pipelines unificadas, formatos de HDR fp16 con AA, formato de HDR 10:10:10:2 para aumentar el rendimiento, un gestor de hilos y asignador de recursos para aumentar la eficiencia del chip… toda la investigación que ATI ha tenido que realizar para Xenos le va a cundir, y algunas de sus características ya están incluidas en la gama R5xx, como es el asignador de recursos o la posibilidad de blending y antialiasing en bufferes fp 16. Es como en la gama R4xx contra la nv4x, las tarjetas de nVidia podían tener un rendimiento mejor, parecido o inferior según el modelo a la tarjeta comparable de ATI, pero mucha gente se las compraba para los Shaders 3.0 (que por cierto, ande andarán)

@PepeLuke:Ojalá ATI le plante cara de verdad a nVidia y le saque los colores, tal y como está haciendo ahora mismo nVidia a ATI con su 7800GTX sin competencia desde hace meses, porque nos ibamos a beneficiar la de dios los consumidores. Pero no sólo me parece exagerado la tabla a la que hace referencia Kynes, sino que diría que es justo al revés, y ATI a duras penas va a rascar bola en esta generación.

Lo digo viendo por ejemplo esta review, en que como no fueron invitados oficialmente por ATI, no tenían acuerdos de confidencialidad por el medio. O los artículos de The Inquirer (vaaaale!! las noticias de este sitio hay que cogerlas con cuidado ;)), en que hablaban de que nVidia había cancelado la 7800 Ultra en cuanto recibió las primeras filtraciones de rendimiento de las nuevas ATI, sencillamente porque vieron que no necesitaban pisar el acelerador y que podían centrarse en otras cosas.

Por no hablar del Crossfire, que si echais un vistazo por ejemplo a este artículo de Xbitlabs (fijaros que también aparece la 6800 Ultra, luego no digais que comparan 850XT con 7800GTX solamente), parece clarísimo que es incluso más petardo que el SLI de nVidia (vamos, que la subida de rendimiento muchas veces es ridícula, y eso cuando funciona).Como ya dije, que conste que me encantaría que ATI contraatacara ahora con fuerza, y los precios de las nVidia por los suelos, luego al revés…y así sucesivamente. Pero de momento no me transmite buenas vibraciones la información escasísima que va apareciendo. Además, me apetecía hacer un poco de abogado del diablo de nVidia para daros pie a continuar el debate

Esa tabla está realizada por ATI, así que hay que tomarla como lo que es. El artículo de hardware analysis

No me entiendas mal, pero ese artículo tómalo con pinzas, y tapándote la nariz. Espera al miércoles y hablamos de rendimiento, porque no me fio ni de las diapositivas del departamento de márketing de ATI, ni de un resentido que admite haber realizado ese artículo para intentar bajar el valor de la acción de ATI por no haberle invitado a la presentación de Ibiza. Solo te digo que se rumorea que en juegos limitados por shaders vamos a ver resultados "sorprendentes"

No me entiendas mal, pero ese artículo tómalo con pinzas, y tapándote la nariz. Espera al miércoles y hablamos de rendimiento, porque no me fio ni de las diapositivas del departamento de márketing de ATI, ni de un resentido que admite haber realizado ese artículo para intentar bajar el valor de la acción de ATI por no haberle invitado a la presentación de Ibiza. Solo te digo que se rumorea que en juegos limitados por shaders vamos a ver resultados "sorprendentes"Sobre lo de la famosa ultra, no te extrañe que nVidia saque un nuevo modelo con mayor velocidad de serie y 512 megas de RAM, es su única opción ahora mismo porque la batalla de las características no la pueden ganar con éste chip. La ventaja del antialiasing transparente la han perdido, no tienen opción de HDR+AA ni de filtro anisotrópico independiente del ángulo… ATI ha estado soltando un montón de mierda (32, 24, 16 pipelines, posibilidad o no de HDR+AA, resultados en el 3DMark desde los 7000 hasta los 9700 puntos, buses de 256 y 512 bits... las R520 han tenido en la mente de los de the inquirer tropecientas formas diferentes) para ocultar los datos reales del chip, y así no permitir a nVidia preparar un contraataque con tiempo, y el problema para nVidia es que la 7800 es una 6800 con esteroides (lo que se le achacaba al R420) pero que no tiene algunas características utilizables desde el primer momento (no como el caso de los shaders 3.0) que si tiene la nueva gama de ATI. No estoy diciendo que la 7800 sea una mala tarjeta, ni muchísimo menos, pero si digo que la 6800 obligó a ATI a ponerse las pilas, y esta gama de tarjetas es la respuesta, mientras que nVidia hizo algo muy lógico, exprimir la vaca porque nadie se esperaba que estas tarjetas fueran más que una R420 con shaders 3.0, como al final ha sido el caso. La 7800 competiría muy bien con una R420 con shaders 3.0, pero el problema es que el R520 y el R420 solo se parecen "estéticamente", funcionalmente son muy diferentes.

El crossfire tiene una serie de problemas muy gordos en la implementación del R420, peeeero son debidas a la propia tarjeta R420. Se utiliza la salida DVI para obtener los datos, y es un DVI simple, con un ancho de banda limitado. Esta limitación no existe en las R5xx, ya que todas las tarjetas incluyen posibilidad de dos salidas DVI dobles, con lo que la limitación del ancho de banda se elimina, y así no tienes esas limitaciones de resolución. En cuanto a rendimiento, veremos como es el rendimiento en las tarjetas que realmente importan, y es en las configuraciones crossfire de la gama R5xx.

No estoy diciendo que la situación sea ni remotamente parecida a la del R300 contra la nv30, en la que la gama FX se metió un tortazo brutal (y a pesar de todo nVidia vendía muchísimo) solo digo que ATI vuelve a estar un paso por delante hasta que nVidia contraataque con un chip nuevo, pero eso es algo que no veremos en unos cuantos meses. A igualdad de rendimiento, la única posibilidad de nVidia es reducir precios para resultar una compra más atractiva, por eso digo que tendrán que bajar los precios.

-

Ai joder, ni Dios va a comprarse esas tarjetas con ese precio. Espera que los precios de las nvidia caigan, asi que esperare a que bajen, pero no se si la 6600 gt va a bajar de precio, porque a lo mejor solo baja la 6800 gt y las otras no.

Despues de esto me estoy pensando, que cual seria mejor una x800gt 256 mb ddr3 o una x1600 pro 256 mb ddr? Buena pregunta esta. A ver cuando salen estas malditas tarjetas, en Octubre? o el año que viene? Buena pregunta tambien porque seguro que se retrasan como todos.

No puedo saberlo porque no tengo tests, la x800gt de todas maneras es mas barata 30€ o mas, y lleva ddr3, la otra no, las que llevan ddr3 son las de nucleo rv540, al menos las otras solo dice 256 mb y nada mas se supone que es la normal. -

pues no se ATi puede que tenga mejor calidad de imagen pero siempre es acosta de rendimiento, y pa que ver bonito a 1FPS, igual esperar el miercoles, jaja porque todo lo que se dice son pura especulaciones y todos dicen algo diferente!!

-

Sobre el precio, tranquilidad. Ese es precio recomendado, casi siempre se vende muy por debajo de ese precio. Sobre el rendimiento, esperemos al miércoles

-

El miercoles las presentan oficialmente o ya las comienzan a vender?

-

Las dos cosas. Se de tiendas que ya las tienen.

-

Las dos cosas. Se de tiendas que ya las tienen.

Joer, pues los de ATI deben haber amenazado de muerte a mucha gente, para que no haya ni siquiera una filtración aunque sea anónima, con las tarjetas ya el las tiendas.

La verdad es que la espera me está matando, aunque tanto secretismo a mí me suena o bien a que van a ser un exitazo y quieren dejar con dos palmos de narices a nVidia de un plumazo, o buen a todo lo contrario y que han ocultado hasta el final un producto que no da la talla….que será, será ;D -

Hombre, con la 7800 no se filtraron datos tampoco. Desde las filtraciones por casualidad que hubieron en el caso de las 6800 (se les escaparon las gráficas a los de [H]ardOCP un dia antes) no hemos "sufrido" filtraciones significativas.

-

pues yo veo los graficos esos de rendimiento un poco fantasiosos o algo tirando al alza no?

-

¿Cómo puedes decir que son fantasiosos o tirando al alza, si no sabemos cómo rinden? Puedes decir, eso si, que la escala de la gráfica no es la correcta, pero eso ocurre en las presentaciones de los fabricantes lo mismo que en las reviews de casi todas las webs (lo que no lo justifica)

-

Esta gama nueva de ATI pinta muuu bien.

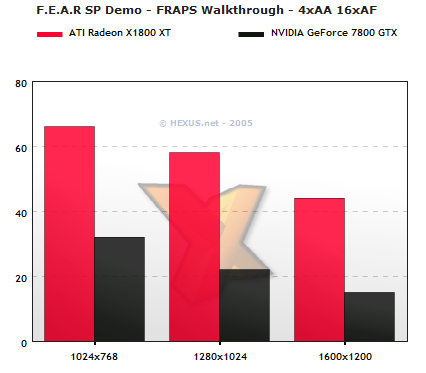

Aqui una comparativa de Guru 3D:

http://www.guru3d.com/article/Videocards/262/

Parece que almenos con el modelo XL no hay tanta diferencia respecto a la 7800 en muchos de los juegos que prueban.

Tengo ganas de ver que tal tira la XT, ha de ser una bestia.

Saludox! -

solo tres botones:

Diferencia de filtrados anisotrópicos. En movimiento la diferencia es mucho más llamativa:

En esta gráfica, lo espectacular es el aumento de rendimiento con dynamic branching activado, mientras que en las tarjetas nVidia no mejora el rendimiento.

Aqui un ejemplo de lo que va a verse en los juegos que vienen

Se puede decir que son ejemplos elegidos, y es cierto, pero el problema de estas tarjetas es que no es potencia bruta y punto, sino que son tarjetas muy preparadas para el futuro. El dynamic branching (uso de condicionales en shaders) va a ser muy útil en juegos futuros debido a la facilidad para programar.

Ah, una última cosa, todavía no se ha visto el rendimiento con HDR+AA, parece ser que el parche del FarCry está al caer…