jajaja que tochos más didacticos

Saludos makina

Mensajes

-

RE: Nueva8800GTS 512MB/ <300€!

-

RE: Los Router ADSL2+ no sincronizan bien con ADSL

Estos de linksys a ver si se espavilan… todos lso firms son iguales y si fuera que son perfectos... con mi anterior GX2 tampoco podía ver la calidad de la señal. En las capturas que pones no se ven los datos de SNR y ateniación solo parte la info de la conexión ADSL.

Por cierto que tal te va el WFI con ese router?? Yo he pasado de un Linksys WAG54GX2 a un D-Link 2740B y las dos veces me ha pasado que al principio llegan a toda la casa perfectamente y con el paso del tiempo empiezan haber partes a las que no llega... que mala suerte tengo... 150€ de router para que el WIFI no me llegue bien al sofá, y ni cambiando una de las 3 antenas por una direcccional de 6 dbi mejora la cosa... :verguen:

Saludos y que no te falle jejeje

-

RE: Nueva8800GTS 512MB/ <300€!

Wuenas de nuevo

Era porque inducia a confusiones

jejeje si… puede que lo explicara mal :risitas:

Uhm creo que no me he explicado muy bien… Lo que queria decir es que por mas independencia que le des a las instrucciones de renderizado, de tal manera que la cpu haga las minimas llamadas, si metes mas efectos/modelos/shaders o lo que sea, vas a tener que hacer mas llamadas necesariamente. Ese es el "problema" que veo. Es decir, poniendo un ejemplo irreal, si cada siguiente parte de un juego duplica las llamadas a una api, y el procesador no duplica su rendimiento, llegara a hacer cuello de botella. Esto es a lo que me referia :sisi: (si bien la evolucion de los juegos no creo que sea asi, es un ejemplo exagerado para que quede claro).

No necesariamente. Las nuevas funciones gráficas muchas veces se idean no para lograr mejores gráficos si no para ser independiestes de la CPU. DX10.1 por ejemplo es otro salto más en ese aspecto. Se intenta que todo se haga dentro de la gráfica y que la CPU únicamente se encarge de mandarle a la gráfica las transformaciones de vértices. Aunque con DX10.1 incluso algunas transformaciones ya se llevan a cabo en el interior de la GPU dependiendo de como se programe el motor. Aunque también es cierto que hay tanta cantidad de polígonos por frame en juegos como Crysis que aunque la CPU no haga nada más que eso le es ya suficiente jejeje.

Además una GPU es mucho más potente en cálculos matemáticos con lo que tener una CPU por medio solo relentiza el proceso de renderizar imágenes 3D. Las gráficas multinúcleo y con caché integrada al estilo de las CPU creo que serán el primer paso.No entiendo lo que quieres decir a que mande a la CPU los shaders :S

El resto del parrafo es lo que habia comentado aunque creo que lo he vuelto a explicar mal :vayatela:

aunque creo que lo he vuelto a explicar mal :vayatela:Las llamadas a una API saturan al procesador, pero tambien llenan el bus de datos de la grafica (pcie/agp), y hacen que esta trabaje (si bien hay llamadas mas o menos "costosas" para la grafica). Es decir, el problema esta en que tanto la cpu como la grafica estan "bloqueados" mientras haces una llamada, y cuando acabas de hacerla, ya tienes la cpu liberada, y le puedes pasar mas datos a la grafica. De esta manera aunque tengas otro procesador, no podras hacer otra llamada a la vez, porque el bus de datos esta ocupado transfiriendo informacion.

Esto era lo que queria decir, espero que haya quedado un poco mas claro ahora que estoy de un patoso… :nono:jeejje lo puse un poco liado la verdad. Sólo me referia a que la hay motores gráficos que hacen muchas llamadas al API y que ese se las manda a la CPU para procesarlas. Sólo eso :muerto:

Tú puedes mandar llamadas al API y por consiguiente a la CPU y ésta no se "bloquea" mientras le queden MHz "libres" jejeje. Sin por cada llamada la CPU no pudiera continuar con otra hasta que no la terminara los juegos no funcionarían :risitas:

Tienes razon, me he columpiado :muerto: . Solo me habia fijado en resoluciones interesantes para la mayoria de los mortales como bien dice Neptunno, alrededor de 1280x1024 o maximo 1600x1200 :rollani: que ahi si que tira de coña la gts

jejeje que me digas que es una GTX es más realista y que con OC altito la supera casi siempre o siempre también, pero una Ultra no es

. Pero esta claro que por el precio está muy bien. Pero no se ha de engañar nadie que nos estan vendiendo tecnología "antigua" y que además ni una Ultra mueve el Crysis a alto detalle con lo que son buenas tarjetas pero no van sobradas pensando en el futuro.

. Pero esta claro que por el precio está muy bien. Pero no se ha de engañar nadie que nos estan vendiendo tecnología "antigua" y que además ni una Ultra mueve el Crysis a alto detalle con lo que son buenas tarjetas pero no van sobradas pensando en el futuro.Saludos!

-

RE: Nueva8800GTS 512MB/ <300€!

Cuando utilicé la palabra renderizar no me refería a que la CPU sea la que lo hace, ya que a no ser que sea render por software es siempre la GPU la que pinta las imágenes en pantalla.

DX10 y sus nuevos efectos no hacen que la gráfica dependa más de la CPU, al contrario, y lo que se pretende con los V&P Shaders es hacer cada vez más independiente la GPU de la CPU de forma que las transformaciones se realicen en la GPU y no en la CPU por ejemplo. El T&L fué el primer salto en este sentido.

El problema de las "llamadas" no tiene que ver con la GPU, ahi es la CPU la que se satura. Existen motores gráficos que por unas razones u otras realizan muchas llamadas al API ya sea porque no indexan, porque pintan la imagen en varias pasadas o por lo que sea, que este a su vez manda a la CPU u otros que no usan (o lo hacen poco) los Shaders y realizan más calculos en la CPU. Ese tipo de motores son más dependientes de la CPU (engine Doom 3 o HL2 por ejemplo). En esos pasa lo contrario de lo que sucede con Crysis por ejemplo, la gráfica va "sobrada" y es la CPU la que no da a basto, determinando en un mayor porcentaje de lo habitual el rendimiento del engine.

Pero vamos que normalmente es la GPU la que determina que un juego funcione bien o mal.En cuanto a que la GTS 65nm es como una Ultra… aún no he visto un review que diga eso... y menos a altas resoluciones. Que la Ultra sea muy cara y grande estoy deacuerdo, pero que la GTS rinda igual, sea más pequeña y cueste la mitad no me parece que sea cierto.

Saludos

-

RE: Nueva8800GTS 512MB/ <300€!

OpenGL suele estar bien implementado porque normalmente sólo lo usa Carmak… y es uno de los mejores programadores de juegos del mundo jejejeje. El problema de OpenGL es más "complicado". DX te da más facilidades (aunque en el 10 ha desaparecido el Direct Input y Direct Sound 3D) y por ejemplo al portar juegos a Xbox no tienes que reprogramar tanto XDD.

Aunque está claro que las prisas a la hora de desarrollar un juego suelen probocar que el rendimiento no sea tan bueno como podría, muchas veces tampoco se pueden hacer milagros y si queremos HDR, iluminación y sombras en tiempo real, texturas de 2o 4k, texturas volumétricas, modelos con miles de polígonos, físicas realistas, sonido real envolvente, IA avanzada.... suelen pedir más máquina de la que nos gustaría.

Saludos

-

RE: Nueva8800GTS 512MB/ <300€!

Las CPUs cada vez son menos importantes para renderizar los juegos. DX10 acentúa aún más eso con sus nuevas funciones. Las CPUs se encargaran cada vez menos del apartado gráfico y se utilizaran principalmente para la IA y sonido.

Programar un juego en multihilo (otro tipo de aplicaciones es más "sencillo") es bastante complicado ya que en tiempo real son muchas cosas las que a la vez han de sincronizarse (colisiones, gráficos, sonidos, físicas, eventos, etc) y si un por ejemplo un core se retrasa en un cálculo te arriesgas a que todo el rendimiento que podrías haber ganado al dividir las tareas se vaya al tarste. Las CPUs Heterogéneas podrían mejorar eso, pero aún falta para que las veamos…En cuanto a que las CPUs son más complejas... creo que no es así Istarion. Una GPU tiene más componentes internos y externos que una CPU. Pero no soy ingeniero y no sé el porque las gráficas evolucionan mucho más que las CPUs jejeje alguna explicación tendrá jejeje.

Y sobre las nueva GTS… tras el nuevo disipador oficial de nVIDIA para las 8800GT (el de ventilador de 75mm), la GTS sería la 3ª revisión de la GT... no veo un salto como para sacar un nuevo modelo que rinde como una 8800GT OC. Me esperaba una cosa más parecida a la 8800Ultra aunque viendo las velocidades de funcionamiento era de esperar. Habrá que esperar a la Serie 9 para cambiar de GPU...

La ATI 38xx tampoco me terminan de convencer ya que en algunos juegos rinde muy bien pero en otro rinden mucho menos que las nVIDIA.Saludos

-

RE: Nueva8800GTS 512MB/ <300€!

jajajajajaja :risitas:

Que tengas suerte!! ;D -

RE: Los Router ADSL2+ no sincronizan bien con ADSL

Hola

Hombre, si el router te informa de que como en mi caso (aunque ahora ya nop

) tienes mala señal puede que sea cosa del modem del router pero lo más probable es que sea el cableado…

) tienes mala señal puede que sea cosa del modem del router pero lo más probable es que sea el cableado…

Has probado conectando el router a diferentes tomas?? Alomejor tu PTR se ha estropeado... pide a telefónica que te revise la línea que no cobran por ello.Saludos y suerte!

-

RE: K8 to NB Frequency vs SB to NB frequency

Ahora que me he dado cuenta… la ASUS A8N32-SLI tiene NB y SB y la Ultra solo NB... :risitas: y se pueden ajustar la velocidades del Bus de la CPU al NorthBridge y del NorthBridge al SouthBridge.

De ahi que tenga la opción de variar multiplicador (K8 to NB Frequency y SB to NB Frequency) y frecuencia (CPU to FSB Frecuency y SB to NB Frecuency) independientemete.

Puede que sea por eso no?? Para overclockear la CPU únicamente se ha de utilizar el K8 to NB Frequency y CPU to FSB Frecuency no??.

Saludos

-

K8 to NB Frequency vs SB to NB frequency

Hola

En mi anterior LanParty nF4 Ultra únicamente había una opción para cambiar el multiplicador HTT pero en la ASUS tiene varias opciones…Cual se debe variar al aumentar el FSB al overclockear? O disminuyo ambos valores?

¿¿K8 to NB Frequency x3??

K8 to NB linkwidth 16/16

¿¿SB to NB frequency x3??

SB to NB Linkwidth 16/16El Linkwidth se puede dejar en 16/16 aun overclockeando verdad?

Saludos y gracias

-

RE: Que volante me compro?

Pronto sacaran también el rFactor 2. Pero tanto el rFactor 1 como el Live for Speed no se quedan "viejos", si te gusta realmente la conducción son juegos que duran muuucho, gracias en parte a la cantidad de mods, circuitos, extras, comunidades y usuarios que hay.

Si te gustan más los gráficos a la última y nuevas versiones cada año sólo los arcaden suelen complir eso… Si te gusta la simulacion rFactor, Netkar (no sé si lo terminarón al final), Live for Speed, Richard Burns, GP500... son de lo mejor aunque sean aniguos jejeje.

-

RE: 8800GTS Primeras imagenes

Tiene buena pinta… haber si las versiones Overclockeadas se acercan a la 8800 Ultra

Esperemos también que haya más stock que de 8800GT

-

RE: 10ºC de diferencia de estar a 2750 a estar a 2800MHz

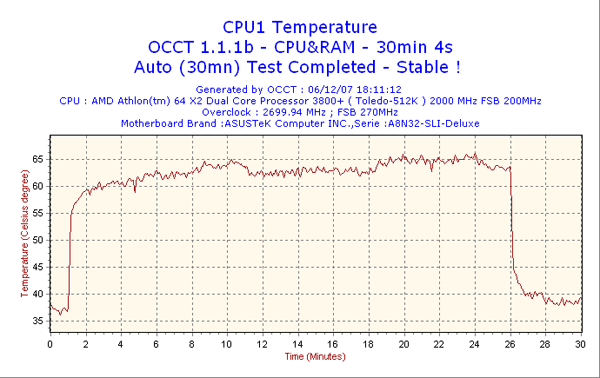

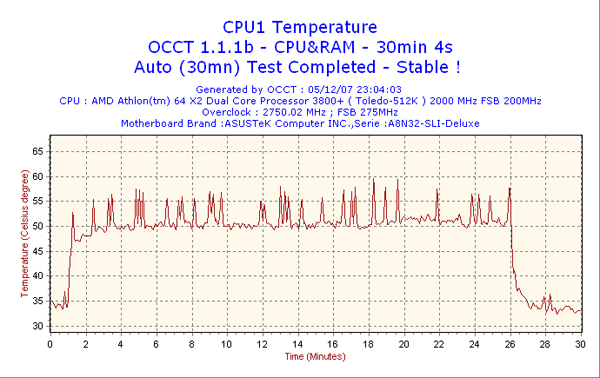

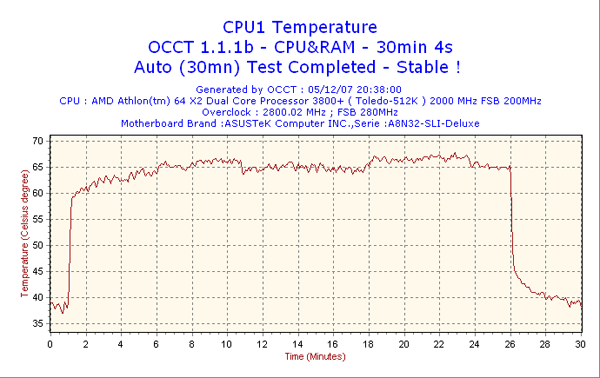

El vCore es el mismo sip. Es cierto también lo que comentas, son un poco raro esos picos… iré probando a diferentes velocidades haber que sale. La temperatura la pilla del SpeedFan 4.33 y es la temperatura del Core no la que informa la placa.

EDIT: A 2700MHz tambien se calienta más que a 2750MHz…

y lo más fuerte es que he repetido el test de 2750MHz y sigue mostrando una gráfica máas "fría"...

y lo más fuerte es que he repetido el test de 2750MHz y sigue mostrando una gráfica máas "fría"...

-

10ºC de diferencia de estar a 2750 a estar a 2800MHz

Hacía mucho que no trasteaba con el PC como antaño y tras un cuelgue extraño que sufrí y aprobechando que tengo que formatear y tal me puse ayer a afinar un poco la máquina :risitas: .

Nunca había utilizado el programa OCCT y me ha parecido muy bueno y completo. Es fiable ese test? Yo siempre he sido de Prime, SuperPI y tests de juegos para medir la estabilidad.

Con él y sus gráficas descubrí que mi micro se calienta muuucho más a 2800 que a 2750MHz, y no hablo de 3-4ºC hablo de mucho más. Os adjunto las capturas para que veais a que me refiero. El Vcore lo tengo a 1.4V.

Por cierto os parecen buenas esas temperaturas? El disipa es un Ninja con el ventilador de 12cm a 1700rpm y pasta arctic Ceramique. Ambiente a unos 25ºC y caja ventilada con 3 ventiladores de 12cm.

Saludos y gracias

-

RE: 8800GTS Primeras imagenes

Ya me extrañaba a mi que continuaran en el mercado las "viejas" GTS y GTX… aunque como "estos" de las gráficas se estan dedicando desde hace tiempo a sacar un montón de modelos para confundir al consumidor tampoco sería de extrañar que no lo hicieran...

Si no fuera porque les sale caro de fabricar el G80 seguro que las dejaban en el mercado. A los que menos les tiene que gustar que descatalogen la GTS y GTX es a los proveedores y tiendas que tengan en Stock que se lo van a tener que regalar a los reyes magos jajaja.Saludos

-

RE: Que volante me compro?

El Colin no lo consideraría un simulador… más bien un arcade muy bien hecho :risitas:

De rallyes el Richard Burn Rally es más simulador. De asfalto el Live for Speed y rFactor serían los más completos, sobretodo este último.

Bye! -

RE: RAM en Windows Vista

El problema no es de AMD ni de Intel, las limitaciones están no solo en el propio sistema operativo sino en el de cualquier procesador de 32 bits.

Con 32 bits "solo" tenemos direcciones de memoria disponibles hasta los 4 GBs, además tenemos que incluir el direccionamiento de E/S de todos los dispositivos del ordenador. Según a partir de que dirección se mapeen esos dispositivos tendremos mas o menos memoria pero nunca podríamos tener los 4 GBs completos.

Con 64 bits no pasa esto y si pasa en Vista algún fallo tendrá el S.O. o la placa, el micro en ese aspecto está fuera de toda duda…

Saludos

faliqui por eso me extrañó que si ASUS indicaba el soporte de 4GB por parte de la placa y si el micro y el S.O. eran de 64 Bits detectara menos de los 4GB…

Volveremos a hacer pruebas utilizando el Memory Hole haber si asi que sale toda la memoria instalada en el S.O.. Lo malo es que el Memory Hole + 2T= Perdida de rendimiento... :susto: -

RE: Donde conseguir DDR PC4000??

No hace falta Hin, nos lo ahorramos ahora y ya ampliaremos a lo "bestia" dentro de poco. Para ser realistas a mi no me hacen falta… era capricho navideño jejeje. Para lo que uso el PC 2GB no va sobrado pero es suficiente. Fué también ver el Vista 64 Bits de mi hermano lo que nos hizo pensar en ampliar mem... se traga 1GB a nada que hagas jejeje. Aunque nos hemos dado cuenta de que al ejecutar algo libera mucha de esa memoria cojida por el S.O. para que la utilice la aplicación iniciada.

Saludos y gracias a todos

-

RE: (SOLUCIONADO) Necesito scaner con adaptador de transparencias

Era para radiografías y digo era porque me han dicho esta tarde (tras estar mareando 2 días) que nunca han usado el adaptador de Transparencias del 1680 Pro jajajaja les costó un dineral porque lo llevaba y ni sabían lo que era (se lo recomndó el anterior informático jejeje), asi que no me complico… pillaremos lo más seguro el Perfection V350 que es en principio similar al 1680 pero mas pequeño, con más resolución y sin el famoso adaptador :risitas: .

Los 4xxx tienen adaptador de diapositivas no transparencias.

Saludos y gracias