Datos definitivos de la gama X1 (ojo 56k)

-

Hombre, con la 7800 no se filtraron datos tampoco. Desde las filtraciones por casualidad que hubieron en el caso de las 6800 (se les escaparon las gráficas a los de [H]ardOCP un dia antes) no hemos "sufrido" filtraciones significativas.

-

pues yo veo los graficos esos de rendimiento un poco fantasiosos o algo tirando al alza no?

-

¿Cómo puedes decir que son fantasiosos o tirando al alza, si no sabemos cómo rinden? Puedes decir, eso si, que la escala de la gráfica no es la correcta, pero eso ocurre en las presentaciones de los fabricantes lo mismo que en las reviews de casi todas las webs (lo que no lo justifica)

-

Esta gama nueva de ATI pinta muuu bien.

Aqui una comparativa de Guru 3D:

http://www.guru3d.com/article/Videocards/262/

Parece que almenos con el modelo XL no hay tanta diferencia respecto a la 7800 en muchos de los juegos que prueban.

Tengo ganas de ver que tal tira la XT, ha de ser una bestia.

Saludox! -

solo tres botones:

Diferencia de filtrados anisotrópicos. En movimiento la diferencia es mucho más llamativa:

En esta gráfica, lo espectacular es el aumento de rendimiento con dynamic branching activado, mientras que en las tarjetas nVidia no mejora el rendimiento.

Aqui un ejemplo de lo que va a verse en los juegos que vienen

Se puede decir que son ejemplos elegidos, y es cierto, pero el problema de estas tarjetas es que no es potencia bruta y punto, sino que son tarjetas muy preparadas para el futuro. El dynamic branching (uso de condicionales en shaders) va a ser muy útil en juegos futuros debido a la facilidad para programar.

Ah, una última cosa, todavía no se ha visto el rendimiento con HDR+AA, parece ser que el parche del FarCry está al caer…

-

Parece ser muy buena la x1800 xl y xt pro con la x1600 pro y xt no parece ser tan buena como esperaba

-

Algunos no me los creo, me fiare mas de los que haga la gente cuando se la compre.

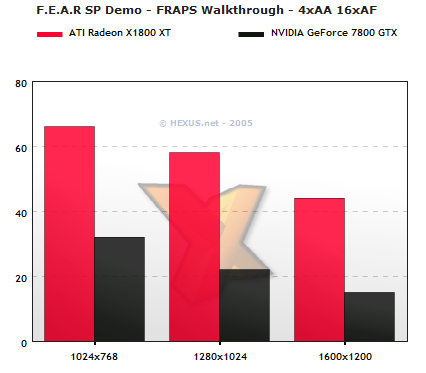

Haveis visto en el FEAR? jajajajaja eso sta vamos, trucadissimo.Aqui veo mucho favoritismo en torno ATi en stoy benchmarks xo weno, ya saldran los VERDADEROS Y REALES benchmarks con ordenadores normales.

-

Hombre, eso díselo a los de Hexus. Si quieres ver esa review, la tienes aquí con la página del fear aquí

Es una review con ordenadores reales, otra cosa es que no te guste lo que ves. Los de nVidia ya han dicho que la versión definitiva del juego funcionará algo mejor en sus tarjetas que esta beta. Ya veremos cuando salga el Quake4, el Elder Scrolls 4 Oblivion, el Call of Duty II, el Fear, los primeros juegos basados en el Unreal Engine 3 (quedan solo meses…) qué es fantasía y qué es realidad

-

Yo pensaba que la x1800xt tiraria algo mas de lo que tira, la 7800gtx es igual a esta o mejor que la ati, segun el juego varia pero creo que no tiene tanto rendimiento como cabia de esperar con 512 mb ddr3.

-

Yo solo digo que el tiempo (y los juegos que salgan) van a poner a cada tarjeta en su sitio. Personalmente creo que una tarjeta está mejor preparada que otra, pero es sólo mi opinión basada en las conclusiones a las que he llegado al estudiar la arquitectura de cada tarjeta.

PD: Si no compráis más de mil tarjetas entre todos, no me llevo comisión… así que venga, rapidito

-

Otra review completita: http://www.xbitlabs.com/articles/video/display/radeon-x1800.html

-

Esta review ya me la creo mas. Los resultados son igualados. Hasta mi grafica funde a una X1800XT en algun k otro juego x'DDDDD (dejadme con mi ilusion! xD)

….

Ahora k me fijo....en el bench del UT04 Metalurgy....COMO COÑO CON AA Y FA, DA MAS FPS A 1280x1024 K A 1024x768!!!!!!!??????????????? (7800GTX) INCLUSO A 1600x1200 DA MAS!!! LOL!!!!

De momento en sta review no se ve k la X1800XT tengo muxo k ofrecer xo weno, lo weno empezara con los bench del Quake 4 (Nvidia), FEAR (Nvidia), UT2k7 (Nvidia)....xD Si todos son partidarios de nvidia nose como ira el tema.

-

Eso se llama estar limitado por la CPU. En este caso, el test es irrelevante ya que no aporta información sobre la potencia relativa entre esas dos tarjetas, por lo que habría que analizar niveles superiores de resolución o calidad gráfica.

Hay dos cosas que me llaman la atención de las reviews de estos primeros dias. Lo primero es lo diferentes que son los resultados en función de la página. Algunas páginas dan diferencias muy altas, otras relativamente bajas. Habrá que esperar a que se asiente la capa de polvo para ver como evoluciona el asunto. Lo segundo es que ATI tiene mucho que mejorar en sus drivers en cuanto a frames por segundo, ya que no es normal que en algunos juegos la X850XT se aproxime tanto a la X1800XT, y supere a la X1800XL. Tiene toda la pinta que existe ineficiencia a nivel de drivers, por lo que lo normal es que el rendimiento aumente en sucesivas versiones.

¿Por qué dices que el Quake4, el Fear o el UT2007 van a funcionar mejor en tarjetas nVidia? ¿Porque nVidia paga por publicidad? No hay que escarvar mucho para encontrar muchos casos de juegos patrocinados por nVidia que funcionan mejor en tarjetas ATI, como el caso del FarCry, Splinter cell, Painkiller, Battlefield 2… Además, en el caso concreto del UT2007 Epic ha afirmado que va a utilizar "extensivamente" el dynamic branching, así que...

Y sobre lo de mucho que ofrecer... Bueno, si no consideras mucho que ofrecer a la mejora de calidad gráfica que proporciona el hecho de HDR+AA, anisotrópico sin depender del ángulo y trilineal en todos los niveles de texturas (los que hayan sufrido el shimmering saben la gran ventaja que ésto supone) o la decodificación por hardware de H264, el codec que utilizarán tanto blu-ray como HD-DVD (que recordemos que las CPU actuales no pueden con él en tiempo real) entre otras mejoras menos "apreciables" desde un punto de vista no-técnico.

PD: Se que mi punto de vista no es objetivo, estoy viendo más las posibilidades técnicas y la implementación tecnológica de la gama que el rendimiento con juegos actuales. Me puedo equivocar, pero me parece que las diferencias deben tender a más con el paso del tiempo. Esto no hace que la 7800GTX sea una mala tarjeta, ni mucho menos (Hoy es la mejor, dentro de un mes no) y su relación calidad-precio es muy buena, magnífica, pero lo que me atrae más es las posibilidades que tiene esta arquitectura, a parte de que todavía no sabemos los precios reales de tienda de las tarjetas ATI. Tiene una flexibilidad en la programación, en el diseño de los chips (a la hora de seleccionar bloques funcionales)... que permitirá a ATI desarrollarse sobre ella durante mucho tiempo. Es como el R300, un punto de partida magnífico para desarrollar toda una gama, lo que pasa es que esta vez tiene una competencia real, no como en el caso de entonces que competía con la gama FX.

-

Tambien opino que los avances tecnológicos de la nueva serie de ATI (en cuanto a la calidad de imagen) son superiores que los de la serie 7 de nVidia; pero en mi opinion la apuesta que ha echo ATI es muy arriesgada. Como bien sabes, la mayoria de las reviews que puedes encontrar de cualquier gráfica se basan principalmente en el rendimiento y no en la calidad de las imagenes. Llama mucho mas la atencion el echo de que una targeta sea capaz de generar cada vez mas fps, que la implementacion del HDR+AA, etc.. La mayotia de la gente no se fija en esas cosas, solo en el rendiemiento.

Tambien hay gente que opina (yo me incluyo entre ellos) que ¿para que quiero 150 fps a 1280? Quizas seria una mejor idea utulizar toda la potencia de la GPU en generar mas cosas (texturas, renders, etc..) que mejoren la calidad del juego; ya que el ojo humano con 25 fps nota una secuancia continua de imagenes (no nota saltos). En mi caso, prefiero una targeta que de 50 fps pero que pueda poner todos los filtros al maximo y lo mas importante, que la calidad de la imagen sea lo mejor posible.

-

Tambien hay gente que opina (yo me incluyo entre ellos) que ¿para que quiero 150 fps a 1280? Quizas seria una mejor idea utulizar toda la potencia de la GPU en generar mas cosas (texturas, renders, etc..) que mejoren la calidad del juego; ya que el ojo humano con 25 fps nota una secuancia continua de imagenes (no nota saltos). En mi caso, prefiero una targeta que de 50 fps pero que pueda poner todos los filtros al maximo y lo mas importante, que la calidad de la imagen sea lo mejor posible.

Para eso mismo esta ahí la nueva gama de ATI

-

Pero la gran mayoria de la gente no opina de igual forma. Como he dicho antes, en casi todas las reviews lo que prima es el rendimiento y no la calidad de la imagen. Por eso he dicho que me parecia una apuesta arriesgada.

-

Pero la gran mayoria de la gente no opina de igual forma. Como he dicho antes, en casi todas las reviews lo que prima es el rendimiento y no la calidad de la imagen. Por eso he dicho que me parecia una apuesta arriesgada.

Siempre es un riesgo, o eso pienso yo. Cuando diseñas un juego, un S.O. , un micro o una GPU, por ejemplo, pues corres muchos riesgos. De todas maners a Ati no le pintara nada mal con esta nueva generacion. Desde mi punto de vista creo que nvidia y ati tienen, en sus nuevas gráficas, muy buenos productos.

Esperemos que la competencia entre estos dos titanes nos conduzca a unos precios mas bajos en todas las gamas xD. O no es verdad??

Saludos!!

P.D: muy buena investigación, Kynes,

(respecto al tema de este hilo)

(respecto al tema de este hilo) -

Radeon x1800xt tecnologia 0,09 micras, 625mhz de core, 512 de gddr3 a 750mhz, con tan solo 16 pipelines me dice dos

cosas: 1- Arquitectura muy ajustada al maximo 2-El dicho de que las tarjetas ati casi no se calientan va a terminar con

este modelo, fuente de alimentacion de 500w casi seguro y de 75 a 85 grados detemperatura estimo que va a atener el tarjeton este. Que alguien me corrija si me equivoco -

El hecho de tener las unidades de texturas desacopladas de las unidades de píxeles permite una flexibilidad muy superior en el diseño, como se puede ver en la tabla en esta comparativa, por lo que puedes introducir unidades de píxeles a voluntad ya que no necesitas una relación fija con las de texturas (permite aumentar el rendimiento en los casos en los que la limitación son los shaders, con un consumo "limitado" de transistores) manteniendo esos 16 "pipelines" (hoy en día hablar de pipelines es complicado, porque te puedes referir a unidades de texturas, unidades de sombreado de píxeles, unidades de cálculo de profundidad en el búfer Z, unidades de renderizado…)

Fíjate en el esquema de la R520 y de la RV530, la gama media, en esta página. En vez de tener una relación uno a uno entre unidades de píxeles y unidades de texturas como la R520, tiene una relación tres a uno. Esta misma relación es la que va a tener la siguiente tarjeta de la gama, la R580, por lo que el futuro de la gama está ya diseñado y garantizado.

El problema del consumo no es tanto del chip (que tiene su parte de culpa) como de la memoria, es el doble de cantidad con una memoria que necesita mayor tensión (2V en vez de 1'8V que utilizan los chips en la 7800GT) y a mucha mayor velocidad. Si pones esa memoria en una 7800GT también se te dispara el consumo… Solo hay que ver el consumo de una X1800XL, que es superior al de la 7800GT en solo 2'5W. Esta tarjeta, con 256 megas de RAM, supongo que debe estar algo por encima de 80W, que es lo que consume la 7800GTX, pero no llegaría ni mucho menos a los 110W que se supone que consume la de 512 megas. Todo esto no contradice el hecho de que sea una aberración una tarjeta con ese consumo. Una comparativa, aqui: http://www.xbitlabs.com/articles/video/display/radeon-x1000_14.html

-

texturas desacopladas de las unidades de píxeles unidades de sombreado de píxeles, unidades de cálculo de profundidad en el búfer Z, unidades de renderizado…

kynes yo me pierdo por el camino

¿Donde has aprendido tanto?

¿Donde has aprendido tanto?A mi lo que me llama la atencion son los numeros de los mhz de la tarjeta son muy altos y seguro que generan mucho calor. Supongo que eso es lo que nos nos depara el futuro

pd: si tienes una tarjeta vieja tanto 7800 como x1800 te van a satisfacer.

No puedes pedir que un mercedes sea como un bmw