Test De Prueba Real Nvidia Gtx Titan,single-sli-tri Sli,4 WAY SLI

-

No creo,pueden sacar diferencias grandes en juegos exigentes y alta resolucion,viendo como le tira sleeping dogs a 2560x1600,se ve que esas graficas a alta resolucion van muy bien,pero en juegos menos exigentes y a 1080p no sacaran tanto a la 680,los driver deben de mejorar,lo que si podria sacar mucho es el 4way a un 4way de 680,le podria sacar un buen margen,sobretodo con multimonitor y alta resolucion en los juegos mas exigentes.

Saludos

La arquitectura es la misma que la de las GTX 680, o sea que la gente se olvide de hacerse pajas mentales de 70-80% extra. De la misma forma que por otros lados se dice que sólo se saca un 20% respecto a otras monogpu, no caigamos en exagerar hacia el otro lado.

Las mejoras más grandes vendrán de aplicaciones muy limitadas por shaders o por ancho de banda, y sleeping dogs parece un caso bastante bueno cuando se usa en él, además de todas estas técnicas de GPGPU escritas al dedillo para GCN que tanto gusto tiene por ellas AMD (ver drivers beta 314.14 de nvidia y su impresionante mejora en Sniper V2, comprobado que es por esto), usa Supersampling así que es un caso directo donde el ancho de banda se vuelve muy importante.

Pero vamos, algún ajuste extra puede aparecer, pero va a ser para mantener como mucho un 50% de diferencia con las GK104, y gracias. Ojo, que media no es lo mismo que el rendimiento en una prueba concreta, que después pasa lo que pasa… :facepalm:

-

3D Mark 11 xtreme…

Después de Kingpin...el menda..por aire,sin volt-mod y sin gráficas escogidas..

Kpablo..vás a tener que plantearte eso de que escala mal el 4 Way...anodado me hallo..

Salu2.

Por eso comente "segun el articulo" porque no las tengo para probarla yo mismo… :troll:

-

3D Mark 11 xtreme…

Después de Kingpin...el menda..por aire,sin volt-mod y sin gráficas escogidas..

Kpablo..vás a tener que plantearte eso de que escala mal el 4 Way...anodado me hallo..

Salu2.

Que bestialidad de resultados

-

La arquitectura es la misma que la de las GTX 680, o sea que la gente se olvide de hacerse pajas mentales de 70-80% extra. De la misma forma que por otros lados se dice que sólo se saca un 20% respecto a otras monogpu, no caigamos en exagerar hacia el otro lado.

Las mejoras más grandes vendrán de aplicaciones muy limitadas por shaders o por ancho de banda, y sleeping dogs parece un caso bastante bueno cuando se usa en él, además de todas estas técnicas de GPGPU escritas al dedillo para GCN que tanto gusto tiene por ellas AMD (ver drivers beta 314.14 de nvidia y su impresionante mejora en Sniper V2, comprobado que es por esto), usa Supersampling así que es un caso directo donde el ancho de banda se vuelve muy importante.

Pero vamos, algún ajuste extra puede aparecer, pero va a ser para mantener como mucho un 50% de diferencia con las GK104, y gracias. Ojo, que media no es lo mismo que el rendimiento en una prueba concreta, que después pasa lo que pasa… :facepalm:

Claro es que es la misma generacion,tanto la 680 como la Titan,no se pueden pedir milagros,aunque como bien dices en juegos concretos que usan tecnicas GPGPU y a alta resolucion la Titan si pueden sacar un buen margen a la 680.

Luego se acuso mucho a Nvidia de patrocinar juegos para que no tiren en AMD y ahora no veo esas quejas,con juegos metiendo SS a saco o tecnicas GPGPU,ademas lo del pelo en Tom Raider,que parece quita bastante rendimiento incluso en AMD.

A mi personalmente me parece bien que se metan fisicas para hacer mas realistas los juegos,aunque me gustaria que fuera algo para todos,pero de momento las fisicas que veo por directcompute no me parecen tan buenas como las de PhysX,mismamente los efectos del pelo en Alice Madnes,me parecen bastante buenos y no pide demasiados recursos,ademas que no es solo el pelo ese juego tiene buenas fisicas.

saludos

-

Claro es que es la misma generacion,tanto la 680 como la Titan,no se pueden pedir milagros,aunque como bien dices en juegos concretos que usan tecnicas GPGPU y a alta resolucion la Titan si pueden sacar un buen margen a la 680.

Luego se acuso mucho a Nvidia de patrocinar juegos para que no tiren en AMD y ahora no veo esas quejas,con juegos metiendo SS a saco o tecnicas GPGPU,ademas lo del pelo en Tom Raider,que parece quita bastante rendimiento incluso en AMD.

A mi personalmente me parece bien que se metan fisicas para hacer mas realistas los juegos,aunque me gustaria que fuera algo para todos,pero de momento las fisicas que veo por directcompute no me parecen tan buenas como las de PhysX,mismamente los efectos del pelo en Alice Madnes,me parecen bastante buenos y no pide demasiados recursos,ademas que no es solo el pelo ese juego tiene buenas fisicas.

saludos

Es que lo de Tomb ni siquiera es un motor de física, que veo a mucha gente confundida, es simplemente una simulación de pelo y nada más. Es como una pieza de un motor de coche, el radiador por ejemplo. Evidentemente el radiador por sí sólo no es un motor de coche, aunque sea una de las partes necesarias para tener uno.

El caso de Tomb está trayendo cola, por cosas como ésta:

http://www.hardocp.com/news/2013/03/05/nvidia_gpu_performance_issues_in_new_tomb_raider

De lo que me quedo con estos extractos:

Unfortunately, NVIDIA didn't receive final code until this past weekend which substantially decreased stability, image quality and performance over a build we were previously provided.

…

Hi Brent, this isn't solely a driver issue. The developer needs to make some changes on their end to fix their issues on GeForce GPUs. This will require code changes to the game.

...

I myself am experiencing slow performance, (R.E. 20's FPS) with GTX 680 SLI at maxed out in-game settings, with FXAA. There is definitely a performance issue that needs resolving. The only thing you can do right now, if you are experiencing slow performance, is turn TressFX off, back to Normal, and try lowering in-game setting, starting with SSAO, to try and improve performance.

O sea, el juego funcionaba MEJOR claramente con una compilación anterior a la usada en el gold, compilación final que nvidia por supuesto no ha visto hasta el lanzamiento básicamente (gaming evolved en acción). Normalmente cuando haces recompilaciones es para mejorar el rendimiento y arreglar problemas, no para hundir el rendimiento (en el rival de tu patrocinador ¬¬).

Es necesario que el fabricante haga cambios en el código para parchear los problemas (o sea, que hay un punto de ineficiencia fuerte en sea como sea que se gestionan ciertos recursos, apuesto a que temas de GPGPU vista la increible mejora de los 314.14 beta de nvidia con SniperV2, algo a lo que le dedicaré un tiempo en breve).

Y por último resulta que hay que bajar muchos parámetros, no sólo lo de TressFX. Se huele el uso de las "optimizaciones" para PC para reventar el rendimiento ajeno. Esto es lo que AMD entiende por "promocionar las tecnlogías abiertas", la de usarlas de tal forma que sean un boicot efectivo a todo menso a su propio hard.

Dentro de un par de meses todo esto estará arreglado y tal, pero mientras a obtener los réditos del bench integrado en el juego (made for gaming evolved!!!) obteniendo puntuaciones hinchadas en cualquier review donde se les ocurra usar Tomb. Esto ya lleva pasando en varios títulos del 2012, así que no debería sorprender, pero a partir de ahora empezaré a llamarle directamente a las cosas por su nombre.

Boicot, puro y duro.

-

Es que lo de Tomb ni siquiera es un motor de física, que veo a mucha gente confundida, es simplemente una simulación de pelo y nada más. Es como una pieza de un motor de coche, el radiador por ejemplo. Evidentemente el radiador por sí sólo no es un motor de coche, aunque sea una de las partes necesarias para tener uno.

El caso de Tomb está trayendo cola, por cosas como ésta:

http://www.hardocp.com/news/2013/03/05/nvidia_gpu_performance_issues_in_new_tomb_raider

De lo que me quedo con estos extractos:

O sea, el juego funcionaba MEJOR claramente con una compilación anterior a la usada en el gold, compilación final que nvidia por supuesto no ha visto hasta el lanzamiento básicamente (gaming evolved en acción). Normalmente cuando haces recompilaciones es para mejorar el rendimiento y arreglar problemas, no para hundir el rendimiento (en el rival de tu patrocinador ¬¬).

Es necesario que el fabricante haga cambios en el código para parchear los problemas (o sea, que hay un punto de ineficiencia fuerte en sea como sea que se gestionan ciertos recursos, apuesto a que temas de GPGPU vista la increible mejora de los 314.14 beta de nvidia con SniperV2, algo a lo que le dedicaré un tiempo en breve).

Y por último resulta que hay que bajar muchos parámetros, no sólo lo de TressFX. Se huele el uso de las "optimizaciones" para PC para reventar el rendimiento ajeno. Esto es lo que AMD entiende por "promocionar las tecnlogías abiertas", la de usarlas de tal forma que sean un boicot efectivo a todo menso a su propio hard.

Dentro de un par de meses todo esto estará arreglado y tal, pero mientras a obtener los réditos del bench integrado en el juego (made for gaming evolved!!!) obteniendo puntuaciones hinchadas en cualquier review donde se les ocurra usar Tomb. Esto ya lleva pasando en varios títulos del 2012, así que no debería sorprender, pero a partir de ahora empezaré a llamarle directamente a las cosas por su nombre.

Boicot, puro y duro.

Ojo que el Tomb Raider yo lo muevo a 60 fps con todo activado (1200p FXAA) con un simple SLI de 480. Claro, cuando la cámara se acerca al pelo, la densidad se dispara y el rendimiento cae hasta los 40 fps. Pero eso también pasa en amd. Si quito el pelo y el High Precision (que ni se nota) puedo subir a SSAAx2 manteniendo 60 fps todo el rato. Así que tampoco es que sea un horror de optimización o un sabotaje a nvidia. Lo que pasa es que el TressFX es algo desproporcionado en distancias cortas tengas nvidia o amd. Y a lo mejor también entra el bajo rendimiento de la serie 6XX en directcompute.

Estoy seguro que ELP3 con sus titanes se retoza en el barro con el Tomb Raider a la resolución que le de la gana.

-

Vamos, lo que lleva haciendo Nvidia desde hace años y años. Lo que ahora afecta a vuestra empresa favorita y ya no es bueno que manden ingenieros para "ayudar" a optimizar los juegos para su hardware, lo que antes era visión de futuro y buenísimo para el usuario, ahora es malísimo.

Esto pasa desde siempre, vamos desde que las empresas de hardware empezaron a patrocinar a las de software y viceversa, y siempre es malo para el usuario final.

-

Ojo que el Tomb Raider yo lo muevo a 60 fps con todo activado (1200p FXAA) con un simple SLI de 480. Claro, cuando la cámara se acerca al pelo, la densidad se dispara y el rendimiento cae hasta los 40 fps. Pero eso también pasa en amd. Si quito el pelo y el High Precision (que ni se nota) puedo subir a SSAAx2 manteniendo 60 fps todo el rato. Así que tampoco es que sea un horror de optimización o un sabotaje a nvidia. Lo que pasa es que el TressFX es algo desproporcionado en distancias cortas tengas nvidia o amd. Y a lo mejor también entra el bajo rendimiento de la serie 6XX en directcompute.

Estoy seguro que ELP3 con sus titanes se retoza en el barro con el Tomb Raider a la resolución que le de la gana.

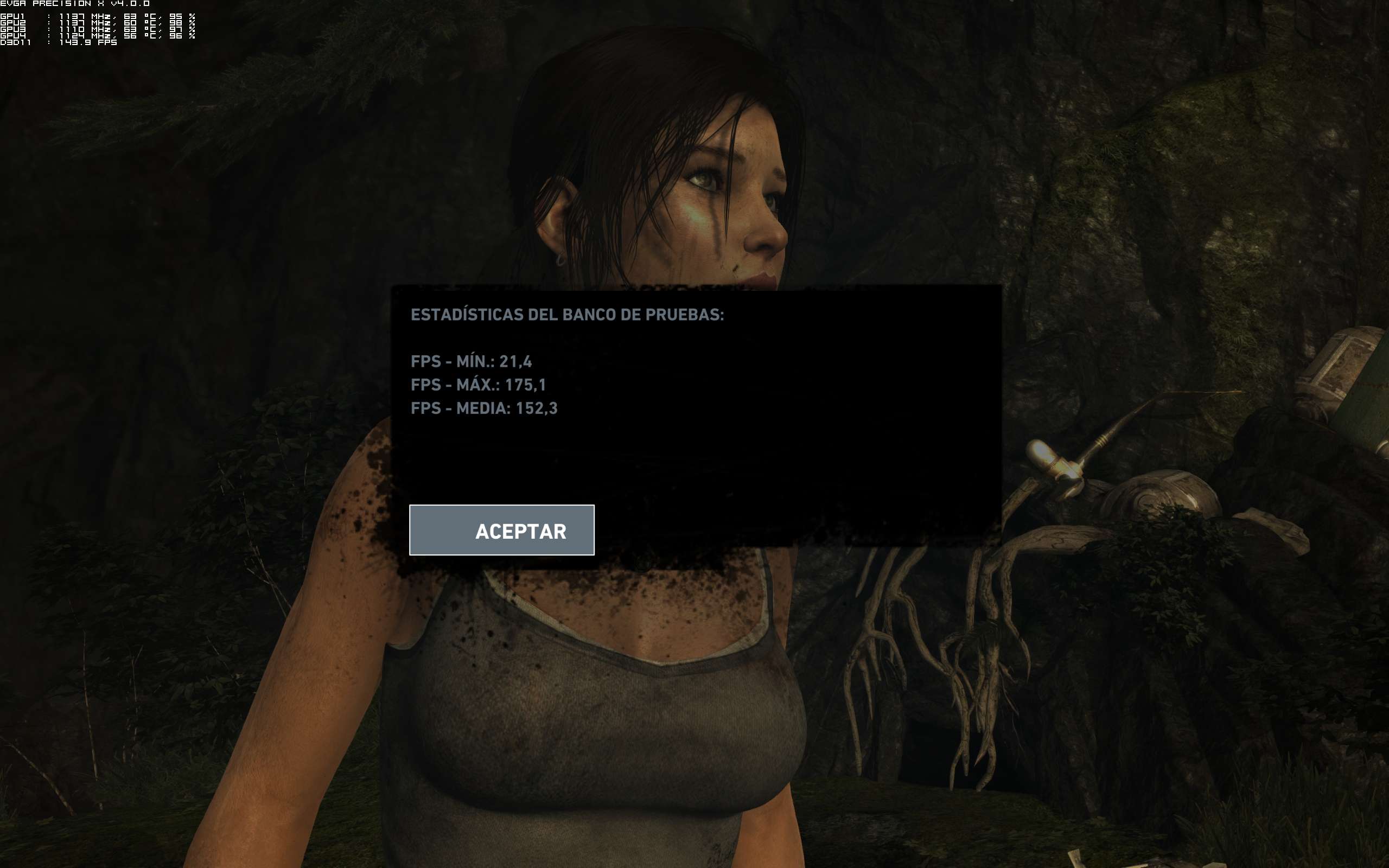

Basicamente así es…no le pongo mas cosas porque no puedo..;)

1600P 4XSSAA todo en ULTRA:

Los mínimos del bench no són reales,són los típicos de los framebuffers de AMD..

Un saludo.

-

@PGS:

Vamos, lo que lleva haciendo Nvidia desde hace años y años. Lo que ahora afecta a vuestra empresa favorita y ya no es bueno que manden ingenieros para "ayudar" a optimizar los juegos para su hardware, lo que antes era visión de futuro y buenísimo para el usuario, ahora es malísimo.

Esto pasa desde siempre, vamos desde que las empresas de hardware empezaron a patrocinar a las de software y viceversa, y siempre es malo para el usuario final.

Perdona, pero las personalizaciones en el comentario y lo de "vuestra empresa favorita" te lo reservas, el tono el justo, que ya sabemos que se empieza señalando con el dedo y acusando de parcialidad y se acaba de otra forma. Yo tengo pruebas de la mala praxis de AMD en varios casos de "optimizaciones", y de forma que jamás se han visto en nvidia, cuya mala praxis si se ha centrado en algo es en bloquear características en su hard (uso propietario de innovaciones).

El peor caso de los últimos tiempos de parte de nvidia fue con Crysis 2, con el tema del "mar de teselado", algo que de todas formas apenas sobrecargaba las gpus (lo que sí sobrecargaba de verdad era el detalle excesivo de teselado en detalles nimios de aceras y similares, eso sí tenía algo de peso y era lo que realmente era cuestionable en su utilidad, lo del mar de teselado… un absurdo en comparación). Pero casos como por ejemplo los de HAWX2 o Lost Planet 2 con su teselado estaban sobradamente justificados, otro asunto es que el hard de AMD tuviera y tenga unos teseladores de pena, que en gran medida hayan retrasado la adopción del teselado, la principal característica innovadoras de DX11, por muchos títulos.

Se han realizado campañas de desprestigio contra el uso de teselado "masivo" por AMD (encontrarás razonable que si dijera "tu marca favorita" no vendría a cuento, ¿verdad?, simplemente como ejemplo te lo digo), diciendo auténticos absurdos como que es totalmente innecesario usar triángulos de 16 píxeles o menos de área, cuando esto no tiene sentidgo alguno (un triángulo de 16 píxeles tiene unas dimensiones aproximadas de 6x6 píxeles, más que visible con bordes incluidos en una pantalla actual, generar triángulos más pequeños sigue teniendo sentido, incluso).

Pero hay implementaciones de efectos que se han hecho en AMD que no tienen sentido alguno. No tiene sentido alguno usar SSAA y añadir cualquier otra tecnología de AA a mayores, es ridículo. Tampoco tiene sentido que el rendimiento caiga como cae con algunos efectos totalmente similares a los implementados en juegos no-GamingEvolved o incluso TWIMTBP que rinden adecuadamente en nvidia (y a veces mejor en AMD).

Está claro, si un juego sale con bench integrado en Gaming Evolved es que ha sido claramente manipulado para ofrecer resultados artificiosos. Se ha cumplido en los últimos Gaming Evolved con benchs, todos básicamente van mal en nvidia. La razón de incluir benchs en juegos tan influidos es simple, es la de afectar resultados de reviews dado que en éstas se tiende a adoptar juegos con benchs integrados ya que son cómodos para los reviewers. Después tenemos juegos que no llevan benchs integrados pero que son considerados muy importantes a nivel técnico, como Crysis 3 o Far Cry3, que curiosamente rinden muy bien en nvidia, así que habría que hablar de 2 niveles de juegos Gaming Evolved, los que ponen al servicio de AMD su rendimiento en detrimento de la calidad al usuario final, y los que la relación Gaming Evolved no se plantea con dicho servilismo, sino como un plus para AMD y el propio desarrollador donde testar y promocionar los productos de ambos conjuntamente.

Hay una gran diferencia entre implementar una característica de forma masiva pero mejorando la calidad gráfica (LP2, HAWX 2) e implementar una característica de tal forma que hunda el rendimiento en el rival aún a costa de perder algo en su propia plataforma (pero mucho menos).

La mejor prueba de esto se puede encontrar en la mejora espontánea de Sniper Elite V2, gran juego que sin embargo está lastrado por una implementación penosa de ciertos efectos por GPGPU. Yo a este juego le tenía el ojo ya encima porque ya sabía qué era lo que lastraba el rendimiento concretamente en origen, con las nvidia. Ya le dedicaré una entrada en el blog y si hace falta dejaré alguna de las imágenes por acá de resultados porque tienen sustancia.

Es un caso muy claro de inserción de características para un lastre impresionante en el rival. Eso ni siquiera se vió en el mencionado caso de Crysis 2 con su "mar de teselado". Y si fuera un caso aislado el de Sniper V2, lo pasaría, pero ya van varios casos muy similares. Y parecer que Tomb es otro caso más a añadir a la lista.

Así también gano yo reviews por un 5-8%... :troll:

-

Vamos a ver..esto vá especialmente para maldo o wendi,ya que sabeis mas de esto que el resto de los mortales..

En Nvidia,al menos mi caso con TITAN,al poco de empezar la partida,ya no se puede jugar con el pelo "fregona" y el Super Sampling activado pues ocurre esto:

El pelo deja de ser pelo y se convierte en una mancha borrosa que vá y viene…ojito también a la Vram consumida según afterburner a mi resolución y 4 SSAA,como sea mas o menos verdad...a ver quien tiene una gráfica con mas de 4GB de Vram y además con la potencia necesaria para moverlo...AMD desde luego no..

Sin embargo con FXAA,el pelo "fregona" se vé "normal"

Sabeis si esto es solo con Nvidia,o sé produce también con AMD,algún tipo de incompatibilidad?

En ambos casos el resto de opciones están la máximo.

Salu2.

-

Vamos a ver..esto vá especialmente para maldo o wendi,ya que sabeis mas de esto que el resto de los mortales..

En Nvidia,al menos mi caso con TITAN,al poco de empezar la partida,ya no se puede jugar con el pelo "fregona" y el Super Sampling activado pues ocurre esto:

El pelo deja de ser pelo y se convierte en una mancha borrosa que vá y viene…ojito también a la Vram consumida según afterburner a mi resolución y 4 SSAA,como sea mas o menos verdad...a ver quien tiene una gráfica con mas de 4GB de Vram y además con la potencia necesaria para moverlo...AMD desde luego no..

Sin embargo con FXAA,el pelo "fregona" se vé "normal"

Sabeis si esto es solo con Nvidia,o sé produce también con AMD,algún tipo de incompatibilidad?

En ambos casos el resto de opciones están la máximo.

Salu2.

Como dices es la vram y un bug del juego. Seguro que si dejas SSAAx4 pero bajas la resolución a 1080p el pelo ya se verá bien.

-

-

Vamos a ver..esto vá especialmente para maldo o wendi,ya que sabeis mas de esto que el resto de los mortales..

En Nvidia,al menos mi caso con TITAN,al poco de empezar la partida,ya no se puede jugar con el pelo "fregona" y el Super Sampling activado pues ocurre esto:

El pelo deja de ser pelo y se convierte en una mancha borrosa que vá y viene…ojito también a la Vram consumida según afterburner a mi resolución y 4 SSAA,como sea mas o menos verdad...a ver quien tiene una gráfica con mas de 4GB de Vram y además con la potencia necesaria para moverlo...AMD desde luego no..

Sin embargo con FXAA,el pelo "fregona" se vé "normal"

Sabeis si esto es solo con Nvidia,o sé produce también con AMD,algún tipo de incompatibilidad?

En ambos casos el resto de opciones están la máximo.

Salu2.

A ver, ya he tenido mi primera toma de contacto sobre el rendimiento del juego con sus distintas opciones, y eso que nos muestras es muy anómalo, para empezar:

Supongo que activas el SSAA dentro del propio juego, por alguna razón extraña éste no me funciona con los 314.14 activándolo desde el menú de configuración del lanzador del juego.

Una vez activado el SSAA 4x, observo una anomalía muy fuerte y "similar" a la tuya en que afecta al pelo, pero de una manera distinta. Como tengo una kepler "pequeña" las diferencias pueden ser explicadas por las diferencias entre modelos, empezando por tener 2 GB de VRAM. En mi caso con 2x SSAA y todo en ultimate el test se comporta normalmente consumiendo unos 1,8GB de VRAM, pero al activar 4x SSAA, además de que el rendimiento se hunde mucho más de lo esperable, se pasa a consumir unos 1,5GB de VRAM, claramente imposible con estas codiciones. O sea, que no es que agote la memoria VRAM sólamente, es que además hace algo muy raro para de pronto dejar un hueco de más de 512 MB de VRAM sin usar, dañando más al rendimiento.

En tu caso la VRAM no es un problema, pero sin embargo tienes ese problema de emborronado, yo con el tema del 4xSSAA también he visto un artefacto gráfico con el pelo, y es que parpadeaba en tonos amarillentos el cabello de Lara cada poco (¿a punto de entrar en modo superguerrero?).

Son fallos extrañísimos, así que diré sólo qué se supone que deberían estar haciendo en ese momento las gráficas respecto al cabello:

Entrar en modo GPGPU, cargar los datos pertinentes y correr los computing shaders de simulación de cabellos (listas linkadas), calcular su posición en el momento dado de simulación del juego y guardar esos datos o en forma de una malla 3D, o incluso pasar de esto y calcular ya en este modo la proyección del cabello en la imagen 2D (e información de sombreado), y pasar a través de un buffer la información del cabello al modo 3D de la gráfica (vuelta a entrar en este modo) para componer la imagen final.

Sea como sea, hay un momento donde se renderiza el cabello, y que se guarda en forma de textura/buffer para uso posterior. El parpadeo es una anomalía muy importante, pero más es el "emborronado", que quizás apoya más a un posible uso de un buffer de imagen de los cabellos. Quizás se calcula y "renderiza" el cabello sin texturizar, y en mi caso debido a la falta de VRAM ocurre que simplemente se muestra a veces sin renderizar totalmente éste, con un color "plano" del buffer pasado desde el modo GPGPU (es posible que haya otros buffers para información adicional como info de brillos, etc), y en tu caso con VRAM de sobra el problema se transforma en algún problema bastante grave de cómo se implementa la imagen final renderizada del cabello al resto de la imagen (parece que han aplicado algún tipo de reescalado de esa imagen prerenderizada de baja calidad para el cálculo de la imagen a la resolución interna del SSAA, y después sufre un downsampling que acaba de joder la marrana).

No tengo ni idea de si pasa en las gráficas AMD, pero parece un problema de cómo se gestionan los pasos de renderizado del cabello en uso del SSAA 4x.

Y por cierto, ¿tú ves el campo de fuerza que cubre a Lara?, sí, el mismo que evita que el cabello se apoye de ninguna de las maneras en sus hombros o su espalda, dejando unos 3-4 dedos de distancia siempre entre cabello y cuerpo.

Está hecha toda una Jedi. Muy profesional el TressFX (Manquiña dixit).

–-----

PD: Qué curioso, al mirar mejor las capturas de ELP3 veo que la "mancha" es bastante simétrica pero NO cubre todo el cabello (se ven las puntas, etc, fuera de la mancha). Tiene un curioso colorido con zonas más claras y otras oscuras, ¿será un mapeado de sombreado/iluminación del cabello?. Pero debería usarse para calcular el valor de color/brillo de cada cabello final, no para aparecer así encima del mismo. :ugly:

Ni idea de qué pasa exactamente, pero vamos, bug gordo sin duda.

-

Entonces que pasa,que no puedo jugar a 1600P con SSAA? si tengo 6 GB VRAM…no entiendo..

Pues Maldo...acabo de hacerlo a 1200p,y sigue ocuriendo lo mismo:

Pues vaya guasa. Yo lo puedo poner a 1200p con SSAAx2 y el pelo se ve bien. No he probado más porque el rendimiento ya no eran 60 constantes y no puedo jugar. Con SSAAx2 también te lo hace? Sí he visto otros usuarios que incluso con FXAA si subían la resolución por encima de 1600p veían mal el pelo.

-

A ver, ya he tenido mi primera toma de contacto sobre el rendimiento del juego con sus distintas opciones, y eso que nos muestras es muy anómalo, para empezar:

Supongo que activas el SSAA dentro del propio juego, por alguna razón extraña éste no me funciona con los 314.14 activándolo desde el menú de configuración del lanzador del juego.

Una vez activado el SSAA 4x, observo una anomalía muy fuerte y "similar" a la tuya en que afecta al pelo, pero de una manera distinta. Como tengo una kepler "pequeña" las diferencias pueden ser explicadas por las diferencias entre modelos, empezando por tener 2 GB de VRAM. En mi caso con 2x SSAA y todo en ultimate el test se comporta normalmente consumiendo unos 1,8GB de VRAM, pero al activar 4x SSAA, además de que el rendimiento se hunde mucho más de lo esperable, se pasa a consumir unos 1,5GB de VRAM, claramente imposible con estas codiciones. O sea, que no es que agote la memoria VRAM sólamente, es que además hace algo muy raro para de pronto dejar un hueco de más de 512 MB de VRAM sin usar, dañando más al rendimiento.

En tu caso la VRAM no es un problema, pero sin embargo tienes ese problema de emborronado, yo con el tema del 4xSSAA también he visto un artefacto gráfico con el pelo, y es que parpadeaba en tonos amarillentos el cabello de Lara cada poco (¿a punto de entrar en modo superguerrero?).

Son fallos extrañísimos, así que diré sólo qué se supone que deberían estar haciendo en ese momento las gráficas respecto al cabello:

Entrar en modo GPGPU, cargar los datos pertinentes y correr los computing shaders de simulación de cabellos (listas linkadas), calcular su posición en el momento dado de simulación del juego y guardar esos datos o en forma de una malla 3D, o incluso pasar de esto y calcular ya en este modo la proyección del cabello en la imagen 2D (e información de sombreado), y pasar a través de un buffer la información del cabello al modo 3D de la gráfica (vuelta a entrar en este modo) para componer la imagen final.

Sea como sea, hay un momento donde se renderiza el cabello, y que se guarda en forma de textura/buffer para uso posterior. El parpadeo es una anomalía muy importante, pero más es el "emborronado", que quizás apoya más a un posible uso de un buffer de imagen de los cabellos. Quizás se calcula y "renderiza" el cabello sin texturizar, y en mi caso debido a la falta de VRAM ocurre que simplemente se muestra a veces sin renderizar totalmente éste, con un color "plano" del buffer pasado desde el modo GPGPU (es posible que haya otros buffers para información adicional como info de brillos, etc), y en tu caso con VRAM de sobra el problema se transforma en algún problema bastante grave de cómo se implementa la imagen final renderizada del cabello al resto de la imagen (parece que han aplicado algún tipo de reescalado de esa imagen prerenderizada de baja calidad para el cálculo de la imagen a la resolución interna del SSAA, y después sufre un downsampling que acaba de joder la marrana).

No tengo ni idea de si pasa en las gráficas AMD, pero parece un problema de cómo se gestionan los pasos de renderizado del cabello en uso del SSAA 4x.

Y por cierto, ¿tú ves el campo de fuerza que cubre a Lara?, sí, el mismo que evita que el cabello se apoye de ninguna de las maneras en sus hombros o su espalda, dejando unos 3-4 dedos de distancia siempre entre cabello y cuerpo.

Está hecha toda una Jedi. Muy profesional el TressFX (Manquiña dixit).

–-----

PD: Qué curioso, al mirar mejor las capturas de ELP3 veo que la "mancha" es bastante simétrica pero NO cubre todo el cabello (se ven las puntas, etc, fuera de la mancha). Tiene un curioso colorido con zonas más claras y otras oscuras, ¿será un mapeado de sombreado/iluminación del cabello?. Pero debería usarse para calcular el valor de color/brillo de cada cabello final, no para aparecer así encima del mismo. :ugly:

Ni idea de qué pasa exactamente, pero vamos, bug gordo sin duda.

Ese fallo de ELP3 y que tienen otros usuarios con resoluciones muy grandes creo que es muy posterior al calculo de la posición del pelo. Cuando todos los cálculos acaban, hay unos pases de postproceso para suavizar el pelo aplicando antialias a cada uno. Ese postproceso es el que creo que no está bien dimensionado para resoluciones altas y por eso se convierte en borrón.

-

Ese fallo de ELP3 y que tienen otros usuarios con resoluciones muy grandes creo que es muy posterior al calculo de la posición del pelo. Cuando todos los cálculos acaban, hay unos pases de postproceso para suavizar el pelo aplicando antialias a cada uno. Ese postproceso es el que creo que no está bien dimensionado para resoluciones altas y por eso se convierte en borrón.

Pues qué quieres que te diga, me parece demasiado emborronado por una mala aplicación de un postproceso que seguramente se limite a aplicar el FXAA o poco más. A mí lo que me extraña es la simetría que tiene el borrón final, y que no afecta en absoluto a las puntas del pelo, lo cual hace que tenga dudas sobre el tema del postproceso o escalado del pelo (al fin y al cabo, el supersampling consiste en un upsampling y posterior downsampling de la imagen). Si fuera así tendría que estar emborronado todo el pelo, no casi todo menos las puntas.

Además que los borrones cuadrarían bastante bien en sus tonos con lo que sería la iluminación a aplicar al cabello.

Pero sea lo que sea, es cosa de cómo se ha hecho el tema. Fina fina, "hoyga".

PD: Por cierto, curioso que la escena del bench integrado del juego, que ocurre al principio nada más salir de la cueva, en bench me da con ultimate unos 41-42 fps, pero en la escena de juego real anda sobre 60-70 fps con facilidad.

Será temas de postproceso, seguro… ¬¬

-

Al estar relacionado con la resolución repito que no creo que sea nada relacionado con cálculos físicos. ManuelG de nvidia dice que ya han visto el fallo y que se lo están mirando.

-

Perdona, pero las personalizaciones en el comentario y lo de "vuestra empresa favorita" te lo reservas, el tono el justo, bla, bla, bla, bla, ….

Nvidia y AMD han hecho trampas siempre que han podido, a mi no me vas a vender la moto a estas alturas de que AMD está haciendo lo nunca visto. Por cierto, no he usado ningún tono en especial, así que mejor te guardas tú el tonito a superioridad que te gastas.

Las optimizaciones y desoptimizaciones son una guarrada las haga quien las haga, pero cuando se empezó con el "meant to be played" muchos ya advertimos que la cosa acabaría en esto y mucha gente lo negó e incluso dijo que eso era bueno para el usuario que así sus tarjetas irían mejor y que la culpa era de ATI por no hacer lo mismo…pues hala aquí tenemos la guerra de maletines y los usuarios "superbeneficiados".

-

Al estar relacionado con la resolución repito que no creo que sea nada relacionado con cálculos físicos. ManuelG de nvidia dice que ya han visto el fallo y que se lo están mirando.

Es que no creo que sea resolución.

Como digo,a 1200p con SSAA X4 también lo hace…y 1200p,no creo que sea una resolución superespecial..

Saludos.

-

Es que no creo que sea resolución.

Como digo,a 1200p con SSAA X4 también lo hace…y 1200p,no creo que sea una resolución superespecial..

Saludos.

1200p SSAAx4 es mucha resolución. Supersampling multiplica la resolución, no es MSAA.

1920x1200 SSAAx2 sería como 2880x1600

1920x1200 SSAAx4 sería como 3840x24002560x1600 SSAAx2 sería como 3620x2260

2560x1600 SSAAx4 sería como 5120x3200Pero no estoy diciendo que sea especial porque consuma mucho rendimiento, que eso te sobraría, es que hay un bug que a partir de una resolución el pelo no se ve bien. En cuanto lo arreglen irás bien.