@Fassou:

Siempre es interesate poder leer un post en el que se documenta con datos la argumentación, pero tendrás que rebajar un poco el tono del texto, ya que es desproporcionado como respuesta al comentario realizado.

En un foro se debate, y nadie tiene que pedir permiso a otro para opinar, ni para tener su propio baremo sobre lo que puede considerar un "refrito".

Salu2!

Si se miente y se dice algo como "sólo le cambian la carcasa y las frecuencias", que cada cuál apechuge con las críticas cosechadas.

Y lo que vulgarmente se conoce como refrito está bastante bien definido, no es algo que tú o yo podamos definir arbitrariamente, de la misma forma que un perro es un perro, y no un gato porque a ti te guste más llamarle "gato" al perro.

El lenguaje está ahí para informar, no para desinformar. Y no, decir que la GTX 770 es una carcasa y unas frecuencias distintas, no es informar, es desinformar. Y si la gente se engaña porque no está informada, estaría bien investigar antes de soltar perlas como ésa.

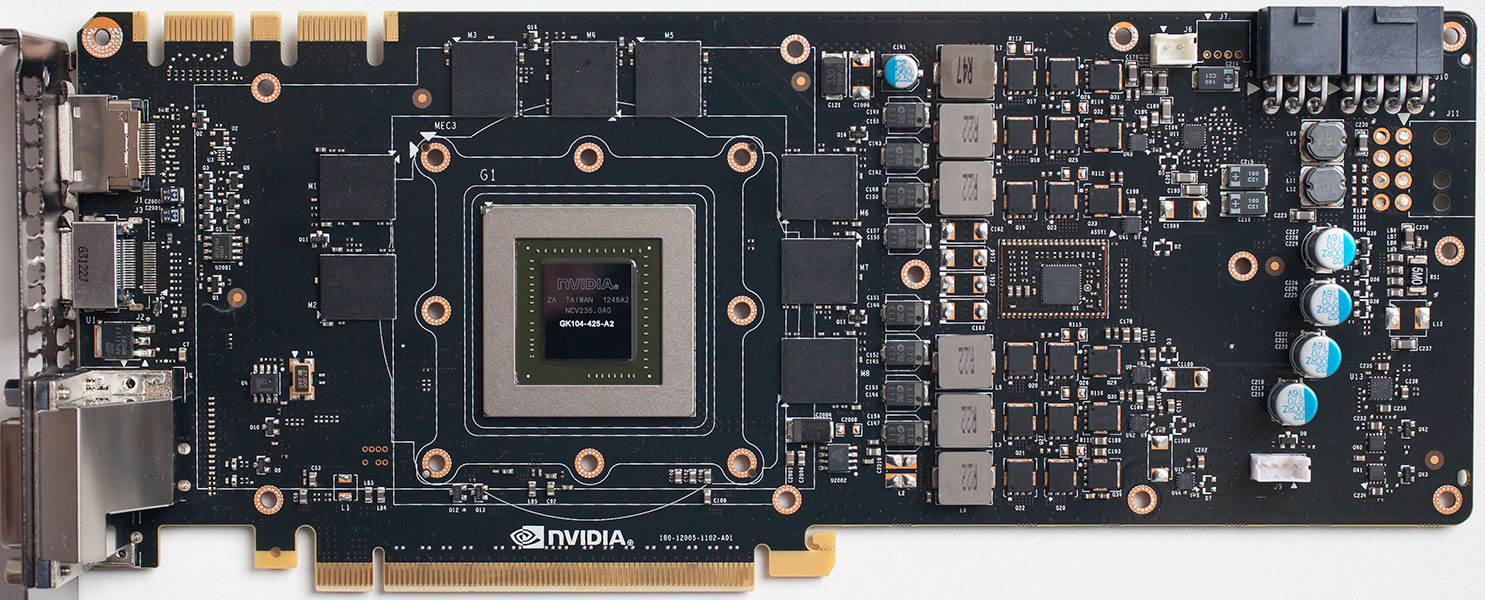

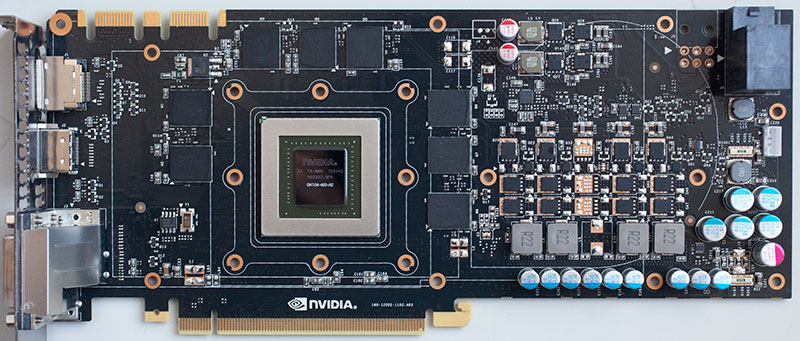

Yo jamás he visto en foros decir que una 7970 GHz es un refrito, y me parece bien aunque se salve de esa clasificación estrictamente por los pelos, pero si no veo esa crítica por ahí contra este modelo, ya me parece de escándalo ver esa cantinela con una tarjeta con un diseño 100% novedoso, en todos los puntos. Claro, usando el GK104, de la misma forma que se usan los Tahiti para la 7990, es el mismo caso. Modelos nuevos con chips similares.

O las HD8000 versión OEM, que éso es ya un refrito pero estrictamente hablando, y ni pío de críticas (y por ahí las montan en equipos de grandes distribuidores).

ALcor:

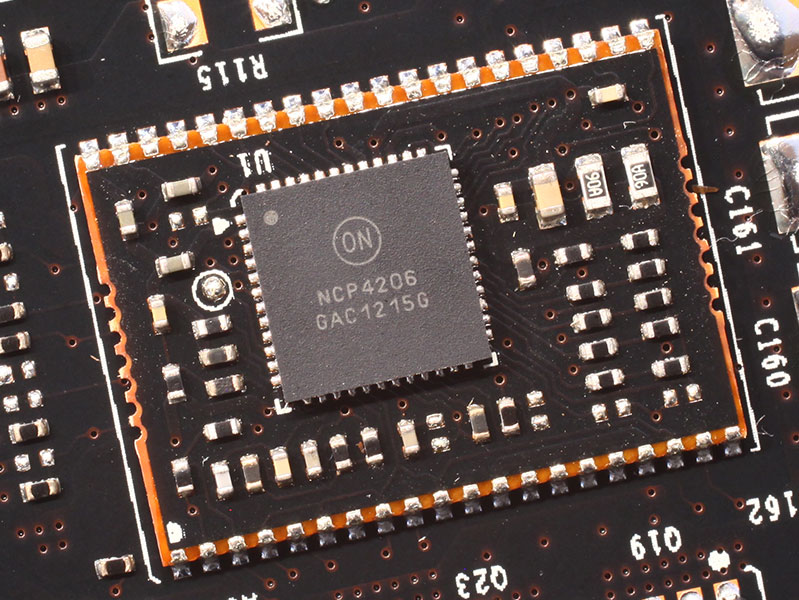

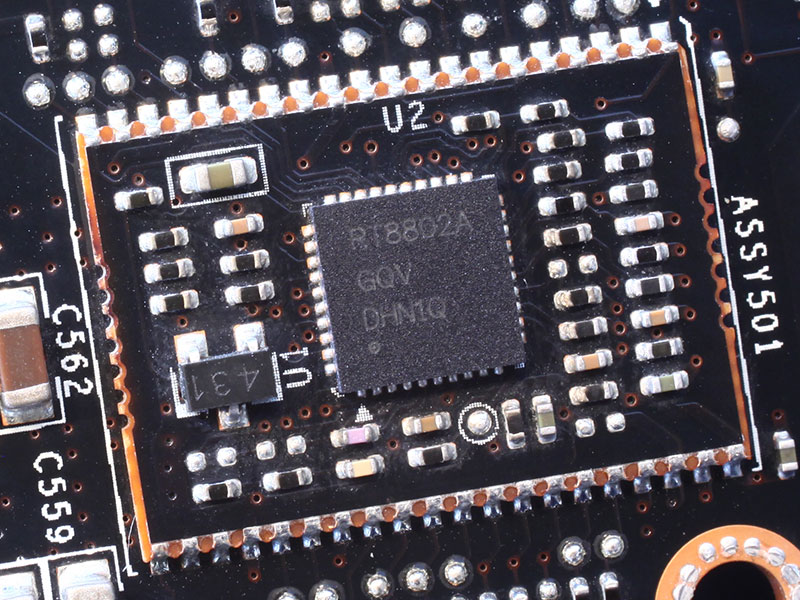

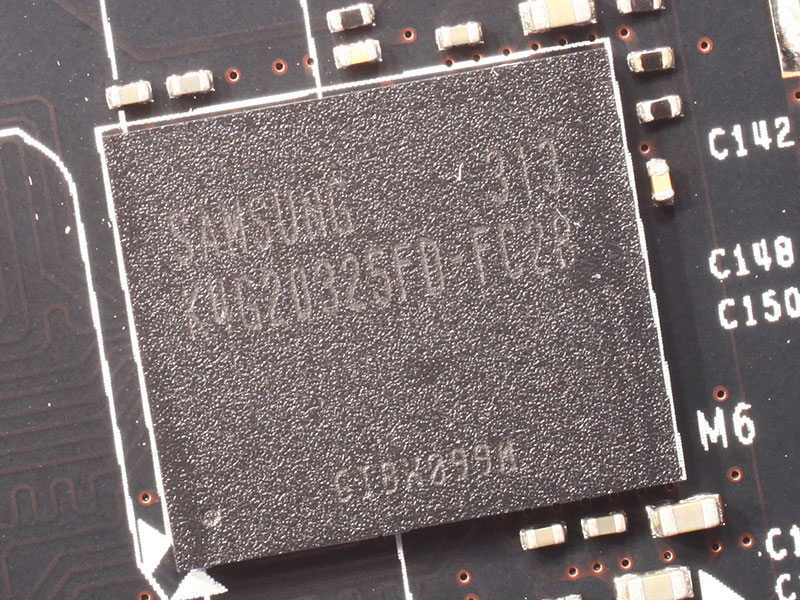

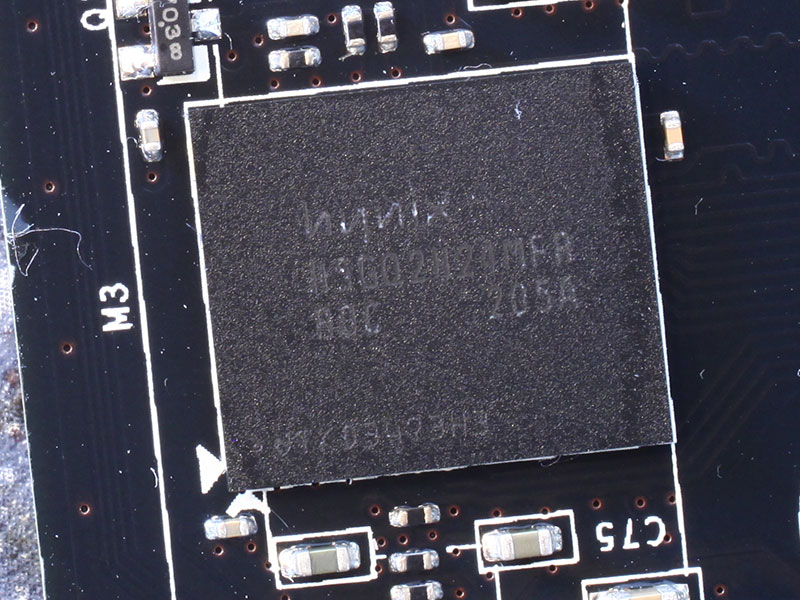

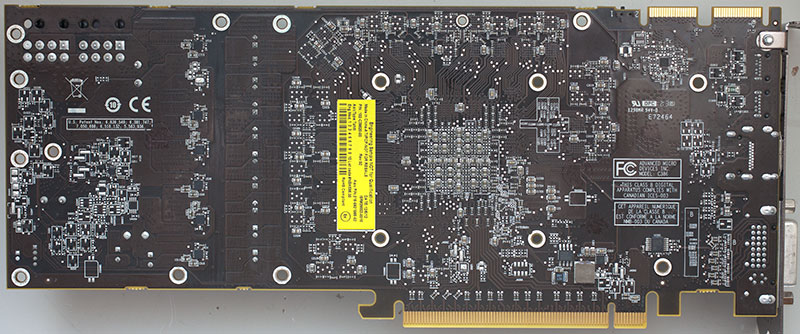

Yo me dirigo a ti como yo considere adecuado, no como tú me ordenes, y menos cuando tú te dedicas a llamar a nadie fanboy o A GRITARR!!!!!, cosa que yo a ti no te he hecho en ningún momento, así que si quieres "respeto", empieza por ti mismo, mis palabras han sido rotundas pero he guardado más las formas, si no te gusta el sarcasmo ya es un problema personal. Y considero más que adecuado darte un repaso informativo a base de fotos sobre la mentira que has dicho, porque eso es lo que has hecho, has mentido. A sabiendas o no, pero lo has hecho.

¿Te tengo que citar para que veas porqué has dicho que es la misma tarjeta? ¿te suenan las palabras "carcasa" y "frecuencias"?

A ti lo que te ha pasado es que el repaso a base de evidencias de imágenes te ha dolido, porque has soltado la perla y te has quedado tan fresco. Que yo sepa no te he llamado ni fanboy, ni tonto, ni nada parecido, así que los gritos, las repeticiones de la misma cosa con marúsculas (el chip, el chip, ¿qué pasa con el chip?, ¿qué pasa que ahora todas las gráficas que lleven un mismo chip son "refritos? Are you serious? venga hombre).

Tú te has ido de un lado porque estabas harto de la "falta de libertad de expresión", pues bien, ESTO es lo que hay cuando se dicen cosas así, que igual si lo que has dicho NO tiene base te da un repaso con evidencias de que las has colado, por ignorancia o por lo que sea.

Ya está bien de la misma cantinela, no redefinas términos, un refrito es la misma tarjeta, mismo PCB, misma memoria y disipadores, y hasta debería tener mismas frecuencias con una etiqueta DISTINTA colocada encima. El mismo producto, con distinto nombre, no una tarjeta "parecida" porque lleve el mismo chip y no comparta después NADA de lo demás.

PUNTO. Una 9800 GT sí es un refrito de la 8800 GT. Una 6770 sí es un refrito de la 5700, pero decir que es un refrito la GTX 770 es querer reirse de la gente.

Te voy a informar de un asunto, si un mismo chip es lo que te sirve a ti para llamar refrito a algo, entonces empieza a decir ese tipo de cosas con las GHz, supongo que no incluyes tarjetas con chips capados, pero también las 7990 llevan ese mismo chip que la 7970, así que también refrito. De todas formas te estás inventando el término refrito, tiene un uso, adáptate a él o invéntate un nuevo nombre para algo que no es un refrito y tú lo estás llamando como tal. Porque si no acabaríamos llamando refrito a una FireGL pro S9000 o S10000 porque llevan el mismo chip que una 7950, Y NO tienen nada que ver.

Por cierto, en vez de tratar de enmierdar con técnicas bajas estilo "y tú más" y "fanboy", estaría bien que admitieras cuando metes la pata, y si no quieres el silencio puede ser mejor que dedicarte a decir que alguien echa pestes sobre tal o cual marca cuando tú a mí no me has visto en este hilo hacer eso que dices, de hecho ni en este foro ni en otros donde posteo actualmente. Me parece muy bien que tengas tal o cual gráfica, en realidad me da lo mismo, te estoy criticando por un tema claro y meridiano, que estás poniendo nombrecitos injustos como muchas veces se ha visto en gente bastante parcial, y que ya está bien de tanto repetir los mismos cuentos que tan tradicionales son por otros lares.

Así que ojito, yo no te he faltado, no te gusta que te dejen con el culo al aire, vale, pero para la próxima, no te inventes la realidad y entonces no te ganarás esas críticas. La GTX 770 no es un refrito, la GTX 770 no es una carcasa distinta para la GTX 680 y frecuencias subidas, y "listo". NO lo es y deberías saber que tengo razón.

Punto pelota.