Nvidia Geforce Titan (gk110)

-

-

Madre mía, la Titan marea con sus números. Tanto económicos, como de rendimiento.

Voy a comprar un décimo de lotería a ver si algún día me puedo comprar una de estas :eoh::eoh:

La verdad es que tiene que ser una gozada tener un (o dos) bichos de estos. La pena es que, como bien habéis comentado antes, no existe una competencia real con AMD. Ya que esta ha elegido la misma estrategia que para los procesadores, pelear en los precios de la gama media/baja y olvidarse del rendimiento de la gama alta.

Esta falta de competencia le deja el camino allanado a Nvidia para poner el precio que les plazca…y si quieres rendimiento brutal, paga una brutalidad. :wall:Un saludo

-

Para los que nos gusta el agua y los que tenéis RL los de EK no pierden el tiempo.

EK Unveils First GeForce GTX Titan Full-Cover Water Block | techPowerUpP.D

En coolmod ya está para reservar 1069€uritos ¬¬:llorar:

-

Bueno,ya han salido un montón de reviews,no voy a poner ninguna,porque creo que ya es de sobra conocido que cada una tira para un lado u otro y que mas o menos,cada uno tiene una web favorita.

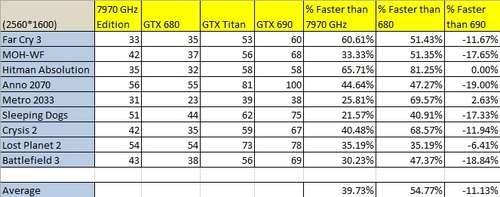

A mí lo que me ha quedado mas o menos claro es una cosa.Estamos hablando de un monogpu bestialmente potente,sobre un 40-50% mas potente que la GTX 680,más si hablamos de 1600p para arriba que es para lo que realmente esta hecha.Que con OC,que al parecer es mas facil de hacer que en las Kepler anteriores e incluso se le puede meter voltaje,aunque poco y limitado por temps,está de tú a tú con la GTX 690,y que tiene que mejorar via drivers…

Parte negativa,sin duda,el precio...terrible precio..quizás,750€ hubiese sido lo suyo..pero que le vamos a hacer,es lo que vale..y yo,voy a pagarlo..

Con suerte,dentro de unos dias,esperemos que pocos,tendreis en primicia,una review en casa,como se han de hacer,si pude ser con 2 o 3 GPUS...entonces vermos realmente lo que dá de si TITAN.

Un saludo.

-

Bueno,ya han salido un montón de reviews,no voy a poner ninguna,porque creo que ya es de sobra conocido que cada una tira para un lado u otro y que mas o menos,cada uno tiene una web favorita.

A mí lo que me ha quedado mas o menos claro es una cosa.Estamos hablando de un monogpu bestialmente potente,sobre un 40-50% mas potente que la GTX 680,más si hablamos de 1600p para arriba que es para lo que realmente esta hecha.Que con OC,que al parecer es mas facil de hacer que en las Kepler anteriores e incluso se le puede meter voltaje,aunque poco y limitado por temps,está de tú a tú con la GTX 690,y que tiene que mejorar via drivers…

Parte negativa,sin duda,el precio...terrible precio..quizás,750€ hubiese sido lo suyo..**pero que le vamos a hacer,es lo que vale..y yo,voy a pagarlo..

**

Con suerte,dentro de unos dias,esperemos que pocos,tendreis en primicia,una review en casa,como se han de hacer,si pude ser con 2 o 3 GPUS…entonces vermos realmente lo que dá de si TITAN.Un saludo.

Ya sabía yo que caerías al final. ;D

Eso sí, aunque la gráfica es muy interesante, el precio está en una órbita totalmente distinta al de las otras en precios, sólo tiene sentido para amantes totales del rendimiento monogpu o los que buscan rendimiento top total en multigpu.

Pero vamos, a qué precio. Ya con el que dices se forrarían, por poder la podían vender perfectamente por la mitad y sacar beneficios, cosas más raras se han visto antes. Aunque claro, eso obligaría a una bajada de precios en todo lo demás y "no es plan".

A mí como no me toque en una tómbola ya veo que ésta no la huelo, ejeje.

Muy buena tarjeta con un precio muy malo.

-

Es verdad que con los precios se han vuelto locos,lo que si parece es que esa Titan va a sacar mas a la 680 sobretodo en juegos Dx11 de lo que saco la 680 a la 580,pero claro pensando que ese GK110 deberia haber sido la gama alta de la serie 600 pues se hace cara,aunque sera como los ferrari o los equipos de sonido de gama alta,sera algo exclusivo para unos pocos afortunados.

Yo las temperaturas no creo que sean nada malas,para un chip tan grande,en guru3d les da la misma temperatura con una con dos o con tres,yo esto lo veo muy raro,ese hombre en vez de caja debe usar un Ataud bajo tierra.

GeForce GTX Titan 3-way SLI and Multi monitor review - Graphics card temperatures

eso sin contar los cuello botella que se ven en algun juego.

http://www.guru3d.com/articles_pages/geforce_gtx_titan_3_way_sli_review,13.html

saludos

-

Bueno, está claro que esta Titan es la sustituta natural del GF110. Era imposible sacarla cuando sacaron el GK104, pero parece que la excusa y, sobretodo, el mal rendimiento de las HD7900 de AMD les ha permitido subirse a la parra a lo bestia. Creo que todos tenemos claro que el GK104 era el chip performance, sustituto natural del GF114 de las GTX560 Ti, pero como AMD falló en sacar una gama alta en condiciones a nVidia le ha salido la jugada redonda, pudiendo doblar el precio de una tarjeta supuestamente gama media-alta pensada para venderse por 250-300€.

En fin, ojalá las cosas cambien en la siguiente generación, desde luego esta Titan es una gran tarjeta a un precio desmesurado.

-

Y lo peor de todo..es que aunque no os lo creais,todas las unidades que llegan la semana que viene a España,que ván ser mas de lo que la gente creé,están ya reservadas…

Osea..que,evidentemente,nvidia sabe muy bien lo que hace,y desgraciadamente habiamos bastantes esperando este chip...esta vez,se lo voy a pagar,pero quizás la próxima vez se lo haga Rita...

-

Es verdad que con los precios se han vuelto locos,lo que si parece es que esa Titan va a sacar mas a la 680 sobretodo en juegos Dx11 de lo que saco la 680 a la 580,pero claro pensando que ese GK110 deberia haber sido la gama alta de la serie 600 pues se hace cara,aunque sera como los ferrari o los equipos de sonido de gama alta,sera algo exclusivo para unos pocos afortunados.

Yo las temperaturas no creo que sean nada malas,para un chip tan grande,en guru3d les da la misma temperatura con una con dos o con tres,yo esto lo veo muy raro,ese hombre en vez de caja debe usar un Ataud bajo tierra.

GeForce GTX Titan 3-way SLI and Multi monitor review - Graphics card temperatures

eso sin contar los cuello botella que se ven en algun juego.

GeForce GTX Titan 3-way SLI and Multi monitor review - DX11: Hitman Absolution

saludos

Las temperaturas son buenas porque no son "accidentales", sino parte del sistema de gestión de la propia tarjeta para ponderar consumo, boost y voltaje, con temperatura.

Tú si quieres le pones como "objetivo" una temperatura baja y la gráfica te la hará, aunque posiblemente perjudicando al boost, los 80º actuales típicos de funcionamiento son resultado de que ésa es la temperatura objetivo, si quieres la subes hasta el límite que nvidia considera seguro, que anda sobre los 95ºC.

A todo esto es independiente el que tú ajustes el ventilador manualmente o con un perfil personalizado (esto último aún no sé si se puede hacer), así que puedes poner a la gráfica que su límite térmico sea alto (90º) pero con una curva personalizada que no le permita pasar de esos 80ºC objetivo actuales, aunque sea a costa de soplar más, y listo. Tienes el boost desatado y una buena temperatura.

La razón de que siempre sea esa temperatura es por lo que te he dicho antes, no es que la gráfica no pueda "enfriar" más, es que no quiere. Tiende a estabilizar su temperatura en el objetivo de temperatura excepto que éste sea tan alto para su disipador que le "cueste" alcanzarlo (95º por lo visto es difícil que lo alcance aunque le pongas que todo su patrón de boost-voltajes-consumo tenga como patrón de temperatura el no superar ese límite).

La forma de conseguir que se "enfríe" más no sería bajar la temperatura límite, que funcionaría pero ajustando parámetros como boost, voltajes y demás. Sino con una curva personalizada de ventiladores.

A veces la gente olvida que esta gráfica busca primar el funcionamiento "elegante" lo cual implica el no ser una puta carraca al lado del oído. Se ve perfectamente que en pruebas de ruido bajo carga su nivel es incluso mejor que el de la GTX 680 o la GTX 690, que ya obtuvieron muy buenas críticas por este punto.

-

Las temperaturas son buenas porque no son "accidentales", sino parte del sistema de gestión de la propia tarjeta para ponderar consumo, boost y voltaje, con temperatura.

Tú si quieres le pones como "objetivo" una temperatura baja y la gráfica te la hará, aunque posiblemente perjudicando al boost, los 80º actuales típicos de funcionamiento son resultado de que ésa es la temperatura objetivo, si quieres la subes hasta el límite que nvidia considera seguro, que anda sobre los 95ºC.

A todo esto es independiente el que tú ajustes el ventilador manualmente o con un perfil personalizado (esto último aún no sé si se puede hacer), así que puedes poner a la gráfica que su límite térmico sea alto (90º) pero con una curva personalizada que no le permita pasar de esos 80ºC objetivo actuales, aunque sea a costa de soplar más, y listo. Tienes el boost desatado y una buena temperatura.

La razón de que siempre sea esa temperatura es por lo que te he dicho antes, no es que la gráfica no pueda "enfriar" más, es que no quiere. Tiende a estabilizar su temperatura en el objetivo de temperatura excepto que éste sea tan alto para su disipador que le "cueste" alcanzarlo (95º por lo visto es difícil que lo alcance aunque le pongas que todo su patrón de boost-voltajes-consumo tenga como patrón de temperatura el no superar ese límite).

La forma de conseguir que se "enfríe" más no sería bajar la temperatura límite, que funcionaría pero ajustando parámetros como boost, voltajes y demás. Sino con una curva personalizada de ventiladores.

A veces la gente olvida que esta gráfica busca primar el funcionamiento "elegante" lo cual implica el no ser una puta carraca al lado del oído. Se ve perfectamente que en pruebas de ruido bajo carga su nivel es incluso mejor que el de la GTX 680 o la GTX 690, que ya obtuvieron muy buenas críticas por este punto.

Pero yo me referia buscando el OC,se supone que al pasar de 80º (aunque por ahora es teoria)bajaria clock y voltaje,teniendo una caja muy bien ventilada quiza fuera mas facil no sobrepasar esa temperatura y podria suponer un mejor OC,en esa misma tabla ponen la 480 a temperaturas altas que puede alcanzar con ventilador en auto y una caja con poca ventilacion,con un perfil de ventilador a mi no me alcanzan esa temperatura y me quedo como 15º por debajo y ademas tengo dos 480,aunque algunas puedan ser mas calientes en esa tabla veo temperaturas altas en casi todas las tarjetas.

Quiza ellos buscan que sea mas silenciosa y otros buscamos el maximo rendimiento aunque suene mas,tambien Nvidia mete perfiles bastante conservadores,los ventiladores solo se aceleran cuando ya esta a 85º la tarjeta,por eso acelerandolos antes es facil que no suba tanto de temperatura,hacerle algun perfil de ventilador que acelere por ejemplo al pasar de 60º,lo que voy es que para la tarjeta que es no tiene mala temperatura.

Tambien quien le ponga RL va a poder subirlas bien,por que seria mas dificil alcanzar 80º.

Bueno, está claro que esta Titan es la sustituta natural del GF110. Era imposible sacarla cuando sacaron el GK104, pero parece que la excusa y, sobretodo, el mal rendimiento de las HD7900 de AMD les ha permitido subirse a la parra a lo bestia. Creo que todos tenemos claro que el GK104 era el chip performance, sustituto natural del GF114 de las GTX560 Ti, pero como AMD falló en sacar una gama alta en condiciones a nVidia le ha salido la jugada redonda, pudiendo doblar el precio de una tarjeta supuestamente gama media-alta pensada para venderse por 250-300€.

En fin, ojalá las cosas cambien en la siguiente generación, desde luego esta Titan es una gran tarjeta a un precio desmesurado.

Hay una cosa que AMD debe agradecer,si Nvidia saca la 680 como gama media a un precio de gama media,AMD lo estaria pasando peor y si luego por ejemplo 6 meses despues saca la GK110 aunque fuera mas recortada podria haber hecho mucho daño,por eso viendo como estan los precios y como ha sido al final la generacion de 28nm,lo mejor es que no se quede un solo fabricante,por que entonces lo pagariamos caro.

Las 79x0 deben ser mas caras de fabricar que las GK104 y si ademaas debe bajar precios para competir con ellas hubiera sido un duro golpe,esta claro que Nvidia no quiere eso supongo para evitar problemas antimonopolio,pero parece que hay pactos o que no tratan de ir a deguello.

Aunque a Nvidia tambien a debido interesarle mucho vender el GK104 como gama alta.

saludos

-

Hay una cosa que AMD debe agradecer,si Nvidia saca la 680 como gama media a un precio de gama media,AMD lo estaria pasando peor y si luego por ejemplo 6 meses despues saca la GK110 aunque fuera mas recortada podria haber hecho mucho daño,por eso viendo como estan los precios y como ha sido al final la generacion de 28nm,lo mejor es que no se quede un solo fabricante,por que entonces lo pagariamos caro.

Las 79x0 deben ser mas caras de fabricar que las GK104 y si ademaas debe bajar precios para competir con ellas hubiera sido un duro golpe,esta claro que Nvidia no quiere eso supongo para evitar problemas antimonopolio,pero parece que hay pactos o que no tratan de ir a deguello.

Aunque a Nvidia tambien a debido interesarle mucho vender el GK104 como gama alta.

saludos

Yo creo que es más lo último que comentas, no creo que a ninguna de las dos les interese destrozar al rival (Y más con los tiempos que corren) más bien les interesa obtener la mayor cantidad de beneficios posible (Como todas las empresas) y en el caso de nVidia es un negocio redondo vender por 500€ de salida una GPU de 300€ o menos, las cifras económicas de la empresa lo demuestran. Vender por 300-400€ Titan, lo pueden hacer y seguramente seguirán teniendo bastantes beneficios, pero ni por casualidad tendrían así los beneficios que han obtenido vendiendo el GK104 a ese precio, así que plantan el GK110 a 1000€ y, quizás, ya la irán bajando de precio a medida que disminuya la demanda.

-

Yo creo que es más lo último que comentas, no creo que a ninguna de las dos les interese destrozar al rival (Y más con los tiempos que corren) más bien les interesa obtener la mayor cantidad de beneficios posible (Como todas las empresas) y en el caso de nVidia es un negocio redondo vender por 500€ de salida una GPU de 300€ o menos, las cifras económicas de la empresa lo demuestran. Vender por 300-400€ Titan, lo pueden hacer y seguramente seguirán teniendo bastantes beneficios, pero ni por casualidad tendrían así los beneficios que han obtenido vendiendo el GK104 a ese precio, así que plantan el GK110 a 1000€ y, quizás, ya la irán bajando de precio a medida que disminuya la demanda.

Desgraciadamente para nosotros,lo que ha pasado es lo que comentais,ni mas ni menos,lo que ocurre,es que muy dificil de digerir para cierto sector que no admite la realidad de lo ocurrido.Tahití falló,costando a la salida 550€,es decir,unos 225€ mas que su antecosora,y su solo aumentando el rendimiento en ese momento en un 36% sobre ella con cambio de generación y nodo incuido…a partir de ahí..ya sabeis la historia..hasta el terrible varapalo en precio de hoy,al mas puro estilo "Intel"...:(

-

Si es "solo" un 39% más rápida que la 7970, qué hay de la 7990? Veo hablar mucho de las 680/690 cuando a parte de ser más caras parece que son más lentas que sus homónimas de AMD no?

-

¡Esta publicación está eliminada! -

Si es "solo" un 39% más rápida que la 7970, qué hay de la 7990? Veo hablar mucho de las 680/690 cuando a parte de ser más caras parece que son más lentas que sus homónimas de AMD no?

La 7990 es de otra clase es un CF mas problematico que una monogpu,los driver esos beta de AMD son un poco extraños,por ejemplo el nuevo 3dmark que te muestra la ventanita de los frames se ve el MS con una sola tarjeta osea que con dos debe ser bastante peor,claro con MS da mejor media,pero a la hora de jugar no es nada bueno,si AMD hiciera un departamento de driver buenos pensando en la mejor experiencia jugable ganaria mucho.

Pero no rendirian igual,yo creo que si se piensa tirar hasta fin de año sin sacar la serie 8000 es por que piensa hacer un rediseño,no puede estirar mas la serie 7000 tal como es,le ha metido boost sobre la marcha,ha tenido que sacar driver que han dado mucho fallo,bajar precios y dar buenos juegos,cuando esas tarjetas jamas deberian haber pasado apuros con un GK104,le deberian haber superado sin problemas sin boost ni historias raras.

A mi desde luego me parece triste que muchas Web tengan la Ares para comparar contra una monogpu,una grafica que no es de AMD y viene bastante oceada,si necesita tarjetas ultra personalizadas y duales para competir contra las mierdecillas de Nvidia mal vamos,por que la 690 a pesar del desproposito de precio son dos chip de gama media,aunque desde luego a precio de oro.

Lo malo para todos nosotros es que son misma generacion de 28nm,por que con intel al fin y al cabo va mas avanzado en proceso de fabricacion y eso es una gran ventaja,pero en mismo proceso no deberia pasar apuros una gama alta contra una gama media.

saludos

-

Si es "solo" un 39% más rápida que la 7970, qué hay de la 7990? Veo hablar mucho de las 680/690 cuando a parte de ser más caras parece que son más lentas que sus homónimas de AMD no?

Krampak…esa són las "cosas" que no entiendo..

Estoy harto de "pasarme por la piedra" a 7970 fritas de voltaje con mas de 1,38V,subidas a 1300MHZ y disipaciones personalizadas en muchos test,con una simple Gigabyte GTX 680 de PCB de referencia,sin poder meter voltaje alguno.Y eso,con los Happy drivers de AMD que saca dia si,dia también para los benchs..

No digo con esto que las GTX 680 estén por encima de las 7970GHZ porque no es verdad,pero tampoco es cierto lo contrario,y menos el valor que algunas reviews le dán.Están muy igualadas.Lo que ocurre,es que según la batería de pruebas,puede haber un par de juegos-bench muy predominantes hacia AMD,que hagan que el % se desnivele..pero ya te digo,yo he tenido chorrocientas 79XX.Y te aseguro que jugando eso no ocurre,es mas,se juega mejor con Nvidia.Sobre todo si es multi-gpu..

Salu2.

-

Ya me imaginaba que alguna explicación tenia que haber xD Yo estoy bastante descontento con la 6990, parece que algunos juegos solo utilizan una parte del segundo núcleo y lo que más me mosquea es que muchas veces reproduciendo vídeo me salta el VPU Recover, sobretodo en youtube, a parte de que tuve que usar el driver sweeper para lograr instalar bien los últimos catalyst. Me uno a la petición de tecnho sobre tus 680 XD

-

Ya me imaginaba que alguna explicación tenia que haber xD Yo estoy bastante descontento con la 6990, parece que algunos juegos solo utilizan una parte del segundo núcleo y lo que más me mosquea es que muchas veces reproduciendo vídeo me salta el VPU Recover, sobretodo en youtube, a parte de que tuve que usar el driver sweeper para lograr instalar bien los últimos catalyst. Me uno a la petición de tecnho sobre tus 680 XD

Lo que comentas,es degraciadamente,muy típico de las soluciones CFX..por poner un ejemplo,el crysis 3,juego que por pirmera vez lleva el patrocinio de AMD,no rula el CF y vá mejor en una sola..sin embargo el SLI rula perfectamente,sin contar los propios bugs del juego que són muchos..para variar..

Un saludo.

-

Lo que comentas,es degraciadamente,muy típico de las soluciones CFX..por poner un ejemplo,el crysis 3,juego que por pirmera vez lleva el patrocinio de AMD,no rula el CF y vá mejor en una sola..sin embargo el SLI rula perfectamente,sin contar los propios bugs del juego que són muchos..para variar..

Un saludo.

Ya esta el kingpin con 4 titanes dandole leña,aunque los resultados no parecen muy buenos parece que alcanzo los 1750 mhz con LN2

KingPin Achieves New World Record With Quad-Way GeForce GTX Titan on Air - Hits 1750 MHz on LN2

and boom goes the TITAN - kingpincooling.com

saludos

-

21k single :ugly: