Test De Prueba Real Nvidia Gtx Titan,single-sli-tri Sli,4 WAY SLI

-

A ver, ya he tenido mi primera toma de contacto sobre el rendimiento del juego con sus distintas opciones, y eso que nos muestras es muy anómalo, para empezar:

Supongo que activas el SSAA dentro del propio juego, por alguna razón extraña éste no me funciona con los 314.14 activándolo desde el menú de configuración del lanzador del juego.

Una vez activado el SSAA 4x, observo una anomalía muy fuerte y "similar" a la tuya en que afecta al pelo, pero de una manera distinta. Como tengo una kepler "pequeña" las diferencias pueden ser explicadas por las diferencias entre modelos, empezando por tener 2 GB de VRAM. En mi caso con 2x SSAA y todo en ultimate el test se comporta normalmente consumiendo unos 1,8GB de VRAM, pero al activar 4x SSAA, además de que el rendimiento se hunde mucho más de lo esperable, se pasa a consumir unos 1,5GB de VRAM, claramente imposible con estas codiciones. O sea, que no es que agote la memoria VRAM sólamente, es que además hace algo muy raro para de pronto dejar un hueco de más de 512 MB de VRAM sin usar, dañando más al rendimiento.

En tu caso la VRAM no es un problema, pero sin embargo tienes ese problema de emborronado, yo con el tema del 4xSSAA también he visto un artefacto gráfico con el pelo, y es que parpadeaba en tonos amarillentos el cabello de Lara cada poco (¿a punto de entrar en modo superguerrero?).

Son fallos extrañísimos, así que diré sólo qué se supone que deberían estar haciendo en ese momento las gráficas respecto al cabello:

Entrar en modo GPGPU, cargar los datos pertinentes y correr los computing shaders de simulación de cabellos (listas linkadas), calcular su posición en el momento dado de simulación del juego y guardar esos datos o en forma de una malla 3D, o incluso pasar de esto y calcular ya en este modo la proyección del cabello en la imagen 2D (e información de sombreado), y pasar a través de un buffer la información del cabello al modo 3D de la gráfica (vuelta a entrar en este modo) para componer la imagen final.

Sea como sea, hay un momento donde se renderiza el cabello, y que se guarda en forma de textura/buffer para uso posterior. El parpadeo es una anomalía muy importante, pero más es el "emborronado", que quizás apoya más a un posible uso de un buffer de imagen de los cabellos. Quizás se calcula y "renderiza" el cabello sin texturizar, y en mi caso debido a la falta de VRAM ocurre que simplemente se muestra a veces sin renderizar totalmente éste, con un color "plano" del buffer pasado desde el modo GPGPU (es posible que haya otros buffers para información adicional como info de brillos, etc), y en tu caso con VRAM de sobra el problema se transforma en algún problema bastante grave de cómo se implementa la imagen final renderizada del cabello al resto de la imagen (parece que han aplicado algún tipo de reescalado de esa imagen prerenderizada de baja calidad para el cálculo de la imagen a la resolución interna del SSAA, y después sufre un downsampling que acaba de joder la marrana).

No tengo ni idea de si pasa en las gráficas AMD, pero parece un problema de cómo se gestionan los pasos de renderizado del cabello en uso del SSAA 4x.

Y por cierto, ¿tú ves el campo de fuerza que cubre a Lara?, sí, el mismo que evita que el cabello se apoye de ninguna de las maneras en sus hombros o su espalda, dejando unos 3-4 dedos de distancia siempre entre cabello y cuerpo.

Está hecha toda una Jedi. Muy profesional el TressFX (Manquiña dixit).

–-----

PD: Qué curioso, al mirar mejor las capturas de ELP3 veo que la "mancha" es bastante simétrica pero NO cubre todo el cabello (se ven las puntas, etc, fuera de la mancha). Tiene un curioso colorido con zonas más claras y otras oscuras, ¿será un mapeado de sombreado/iluminación del cabello?. Pero debería usarse para calcular el valor de color/brillo de cada cabello final, no para aparecer así encima del mismo. :ugly:

Ni idea de qué pasa exactamente, pero vamos, bug gordo sin duda.

Ese fallo de ELP3 y que tienen otros usuarios con resoluciones muy grandes creo que es muy posterior al calculo de la posición del pelo. Cuando todos los cálculos acaban, hay unos pases de postproceso para suavizar el pelo aplicando antialias a cada uno. Ese postproceso es el que creo que no está bien dimensionado para resoluciones altas y por eso se convierte en borrón.

-

Ese fallo de ELP3 y que tienen otros usuarios con resoluciones muy grandes creo que es muy posterior al calculo de la posición del pelo. Cuando todos los cálculos acaban, hay unos pases de postproceso para suavizar el pelo aplicando antialias a cada uno. Ese postproceso es el que creo que no está bien dimensionado para resoluciones altas y por eso se convierte en borrón.

Pues qué quieres que te diga, me parece demasiado emborronado por una mala aplicación de un postproceso que seguramente se limite a aplicar el FXAA o poco más. A mí lo que me extraña es la simetría que tiene el borrón final, y que no afecta en absoluto a las puntas del pelo, lo cual hace que tenga dudas sobre el tema del postproceso o escalado del pelo (al fin y al cabo, el supersampling consiste en un upsampling y posterior downsampling de la imagen). Si fuera así tendría que estar emborronado todo el pelo, no casi todo menos las puntas.

Además que los borrones cuadrarían bastante bien en sus tonos con lo que sería la iluminación a aplicar al cabello.

Pero sea lo que sea, es cosa de cómo se ha hecho el tema. Fina fina, "hoyga".

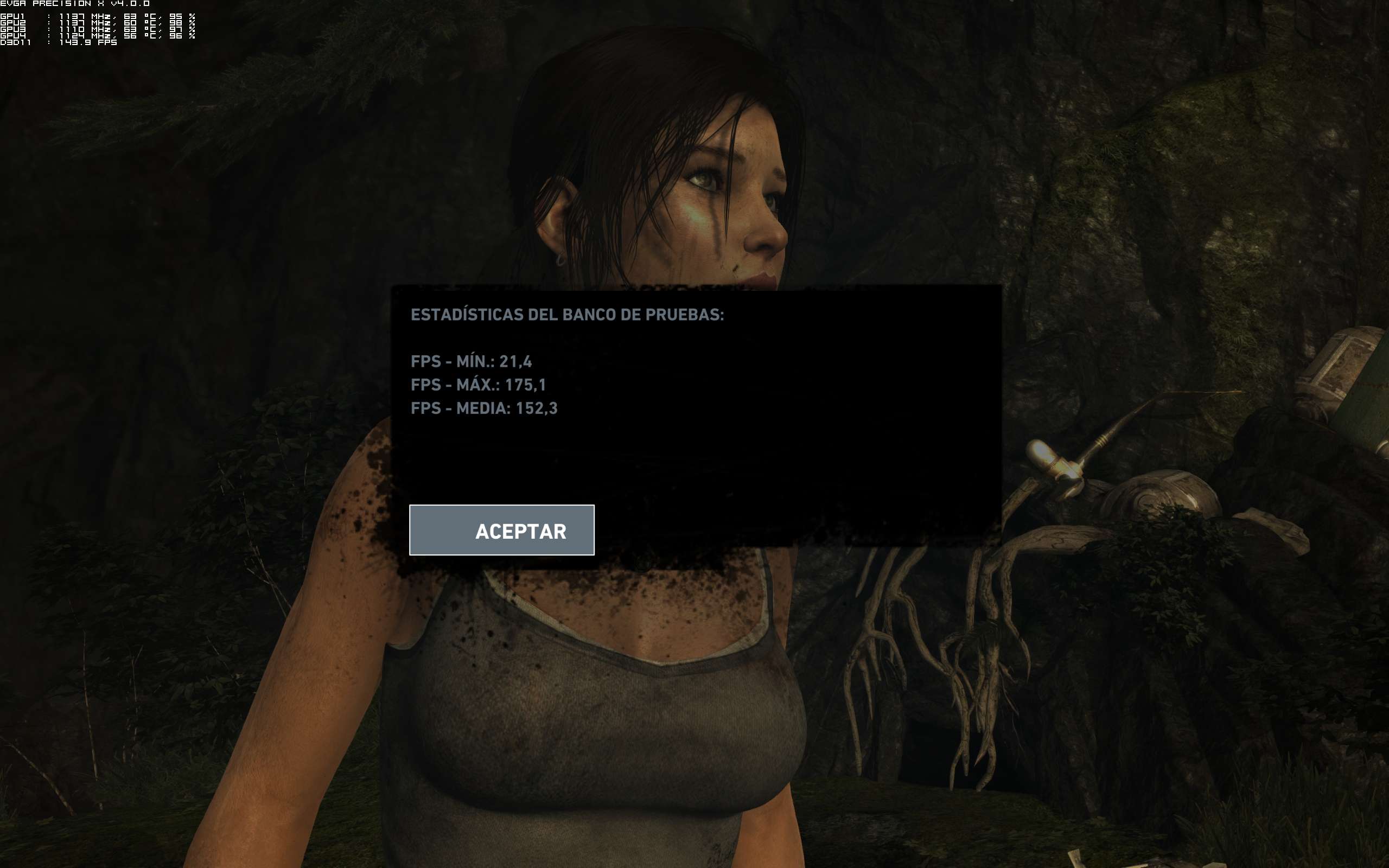

PD: Por cierto, curioso que la escena del bench integrado del juego, que ocurre al principio nada más salir de la cueva, en bench me da con ultimate unos 41-42 fps, pero en la escena de juego real anda sobre 60-70 fps con facilidad.

Será temas de postproceso, seguro… ¬¬

-

Al estar relacionado con la resolución repito que no creo que sea nada relacionado con cálculos físicos. ManuelG de nvidia dice que ya han visto el fallo y que se lo están mirando.

-

Perdona, pero las personalizaciones en el comentario y lo de "vuestra empresa favorita" te lo reservas, el tono el justo, bla, bla, bla, bla, ….

Nvidia y AMD han hecho trampas siempre que han podido, a mi no me vas a vender la moto a estas alturas de que AMD está haciendo lo nunca visto. Por cierto, no he usado ningún tono en especial, así que mejor te guardas tú el tonito a superioridad que te gastas.

Las optimizaciones y desoptimizaciones son una guarrada las haga quien las haga, pero cuando se empezó con el "meant to be played" muchos ya advertimos que la cosa acabaría en esto y mucha gente lo negó e incluso dijo que eso era bueno para el usuario que así sus tarjetas irían mejor y que la culpa era de ATI por no hacer lo mismo…pues hala aquí tenemos la guerra de maletines y los usuarios "superbeneficiados".

-

Al estar relacionado con la resolución repito que no creo que sea nada relacionado con cálculos físicos. ManuelG de nvidia dice que ya han visto el fallo y que se lo están mirando.

Es que no creo que sea resolución.

Como digo,a 1200p con SSAA X4 también lo hace…y 1200p,no creo que sea una resolución superespecial..

Saludos.

-

Es que no creo que sea resolución.

Como digo,a 1200p con SSAA X4 también lo hace…y 1200p,no creo que sea una resolución superespecial..

Saludos.

1200p SSAAx4 es mucha resolución. Supersampling multiplica la resolución, no es MSAA.

1920x1200 SSAAx2 sería como 2880x1600

1920x1200 SSAAx4 sería como 3840x24002560x1600 SSAAx2 sería como 3620x2260

2560x1600 SSAAx4 sería como 5120x3200Pero no estoy diciendo que sea especial porque consuma mucho rendimiento, que eso te sobraría, es que hay un bug que a partir de una resolución el pelo no se ve bien. En cuanto lo arreglen irás bien.

-

@PGS:

Nvidia y AMD han hecho trampas siempre que han podido, a mi no me vas a vender la moto a estas alturas de que AMD está haciendo lo nunca visto. Por cierto, no he usado ningún tono en especial, así que mejor te guardas tú el tonito a superioridad que te gastas.

Las optimizaciones y desoptimizaciones son una guarrada las haga quien las haga, pero cuando se empezó con el "meant to be played" muchos ya advertimos que la cosa acabaría en esto y mucha gente lo negó e incluso dijo que eso era bueno para el usuario que así sus tarjetas irían mejor y que la culpa era de ATI por no hacer lo mismo…pues hala aquí tenemos la guerra de maletines y los usuarios "superbeneficiados".

Lo que faltaba por leer. Perdona, pero ell "tonito de superioridad" es el que tú has empezado a usar a la hora de decir "vuestra empresa favorita" haciendo lo que es una acusación poco velada que no viene a cuento (que yo sepa, tú eres el primero que menciona a los demás y con esa acusación), así que primero respeta, no vengas con esos "tonitos" y después si tal exige tú a los demás que no te vengan con tonitos también.

Y por cierto, con el plan TWIMTBP JAMAS se ha visto que un juego en AMD rinda un 50% menos en éstas que en nvidia con tarjetas similares. Y si quieres ejemplo de las guarradas que ha llegado a hacer AMD coges y te miras los rendimientos con Dirt Showdown, las "optimizaciones" activadas y qué pasa con el rendimiento.

AMD nunca ha necesitado de especial ayuda para tener problemas de rendimiento, de hecho los ha tenido con programas Gaming Evolved como es Dragon Age 2, y algún caso más, que es de los juegos que de lejos peor les ha ido a las gráficas GCN vs Kepler.

Ahora me dirás que eso era un "boicot de nvidia". Te insisto que nvidia, su "especialidad" en estos temas más que hundir el rendimiento rival ha sido la de implementar características propietarias, como PhysX, AA "exclusivo" o el uso de técnicas que le vengan bien.

Por supuesto que han habido casos de "boicot", pero son los menos frente a optimizaciones exclusivas. Y no sé a qué viene un simplón "y tú más" cuando estamos hablando de la situación actual provocada por AMD en juegos actuales, no de lo que hicieron panchito y benito hace 2 días.

-

1200p SSAAx4 es mucha resolución. Supersampling multiplica la resolución, no es MSAA.

1920x1200 SSAAx2 sería como 2880x1600

1920x1200 SSAAx4 sería como 3840x24002560x1600 SSAAx2 sería como 3620x2260

2560x1600 SSAAx4 sería como 5120x3200Pero no estoy diciendo que sea especial porque consuma mucho rendimiento, que eso te sobraría, es que hay un bug que a partir de una resolución el pelo no se ve bien. En cuanto lo arreglen irás bien.

También me ocurre con 1080p y 1200p X2 SSAA…una bug..pero de Nvidia,juego o ambas?

Por cierto,la cuerdas del crysis 3,hasta que no haya parche,nada no?

Un slaudo.

-

@PGS:

Nvidia y AMD han hecho trampas siempre que han podido, a mi no me vas a vender la moto a estas alturas de que AMD está haciendo lo nunca visto. Por cierto, no he usado ningún tono en especial, así que mejor te guardas tú el tonito a superioridad que te gastas.

Las optimizaciones y desoptimizaciones son una guarrada las haga quien las haga, pero cuando se empezó con el "meant to be played" muchos ya advertimos que la cosa acabaría en esto y mucha gente lo negó e incluso dijo que eso era bueno para el usuario que así sus tarjetas irían mejor y que la culpa era de ATI por no hacer lo mismo…pues hala aquí tenemos la guerra de maletines y los usuarios "superbeneficiados".

te puedo garantiazar que los que estamos seguiendo ese hilo no somos muy maniaticos y nos da igual Ati que Nvidia y en especial hace mucho tiempo que leo a Elp3 y a el le da lo mismo siempre a dicho lo que pensaba

Un saludo

-

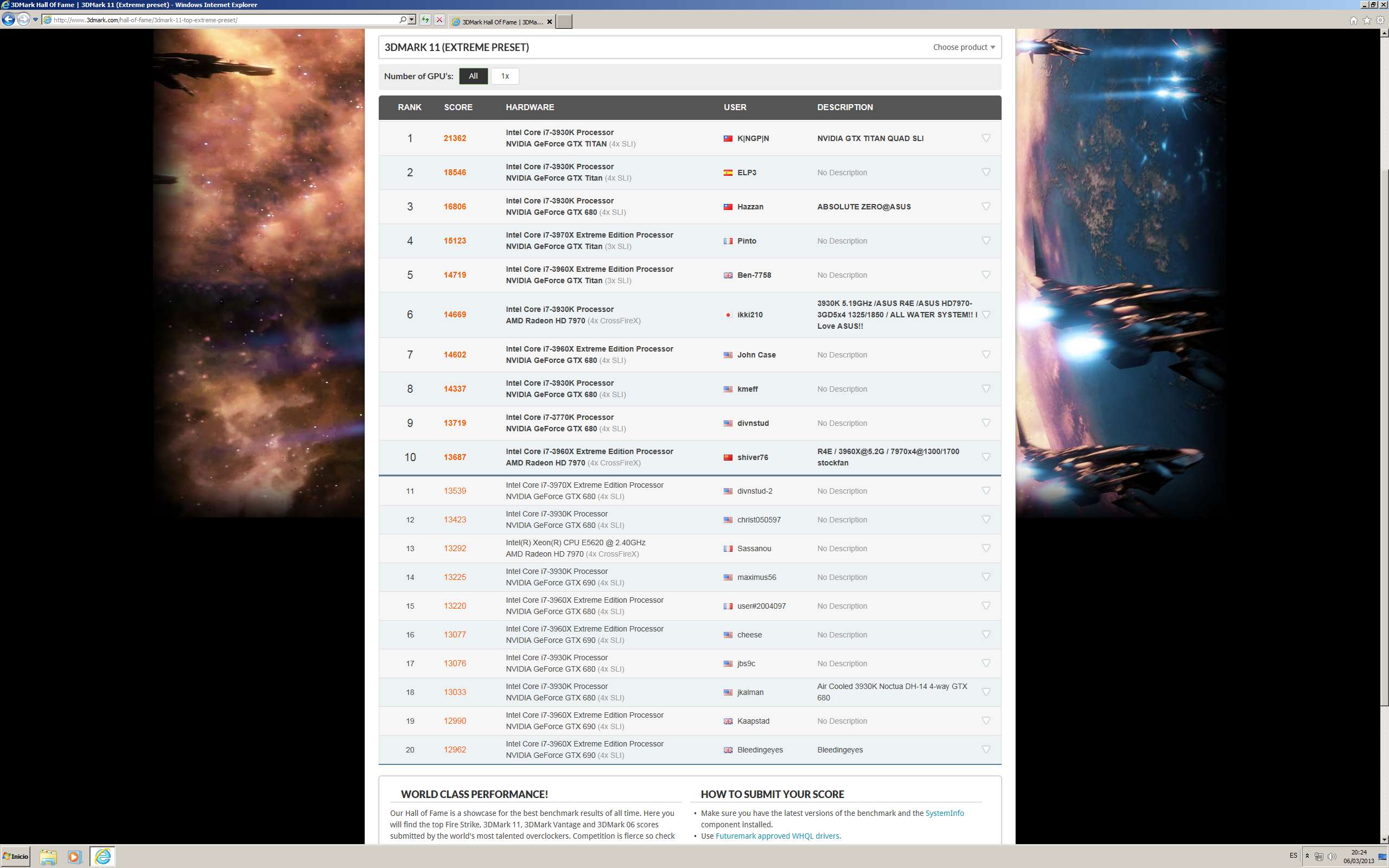

Bueno…ya es oficial:

http://www.3dmark.com/hall-of-fame/3dmark-11-top-extreme-preset/

Después del intocable Kingpin,voy yo..

Lo he tenido que hacer por huevos con el 2011..no me gusta nada esta plataforma,tiene menos rendimiento que el ivy,y además,el micro ya no es capaz de subir de 5,0GHZ..pero los 12 hilos hacen mucho en las pruebas de física y no me ha quedado mas remedio que utilizarla.

Por supuesto las gráficas están de stock,por aire y sin utilizar voltaje..para qué? si no sirve de momento..

Espero que os guste..;)

Un saludo.

-

wOw Felcidades amigo se ve super bien ;D , me uno al grupo de los F5f5f5f5f5f5.

-

Bueno…ya es oficial:

http://www.3dmark.com/hall-of-fame/3dmark-11-top-extreme-preset/

Después del intocable Kingpin,voy yo..

Lo he tenido que hacer por huevos con el 2011..no me gusta nada esta plataforma,tiene menos rendimiento que el ivy,y además,el micro ya no es capaz de subir de 5,0GHZ..pero los 12 hilos hacen mucho en las pruebas de física y no me ha quedado mas remedio que utilizarla.

Por supuesto las gráficas están de stock,por aire y sin utilizar voltaje..para qué? si no sirve de momento..

Espero que os guste..;)

Un saludo.

Enhorabuena.

La que me parece muy buena puntuacion es la de Hazzan,pues son 680,aunque esos van con LN2 y es muy distinto a hacerlo por aire,el LN2 te asegura mas frecuencia tanto en CPU como a las GPU y en esos benchmark se nota.

saludos

-

Hasta la semana que viene no tendré la Titan :wall:

Mientras espero, a ver si me resolvéis unas dudas:

- Drivers, ¿los beta o los WHQL?

- Para overclock, veo que se usa el EVGA Precission, yo estaba acostumbrado al MSI Afterburner, ¿es por algún motivo?

- El overdrive del monitor, la función de dar más de los 60Hz, ¿alguien la ha probado?

- En cuanto al overclock, por lo que leo, conviene dejar el ventilador en auto, y subir al tope linkados el Power y la Temperatura, sin ser necesario tocar el voltaje, ¿no?. Además, vengo de unas GTX 580, no tenían Boost, por lo que no tengo muy claro si hay que tocar el offset o bien eso no hace falta tocarlo y con subir la velocidad básica es suficiente.

Gracias por anticipado.

P.D. Vaya puntuación salvaje, y que gusto da verse ahí, recuerdo cuando hace años metí una puntuación entre las diez primeras la ilusión que me hizo …....

-

Bueno…ya es oficial:

http://www.3dmark.com/hall-of-fame/3dmark-11-top-extreme-preset/

Después del intocable Kingpin,voy yo..

Lo he tenido que hacer por huevos con el 2011..no me gusta nada esta plataforma,tiene menos rendimiento que el ivy,y además,el micro ya no es capaz de subir de 5,0GHZ..pero los 12 hilos hacen mucho en las pruebas de física y no me ha quedado mas remedio que utilizarla.

Por supuesto las gráficas están de stock,por aire y sin utilizar voltaje..para qué? si no sirve de momento..

Espero que os guste..;)

Un saludo.

Enhorabuena ;D

-

Hasta la semana que viene no tendré la Titan :wall:

Mientras espero, a ver si me resolvéis unas dudas:

- Drivers, ¿los beta o los WHQL?

- Para overclock, veo que se usa el EVGA Precission, yo estaba acostumbrado al MSI Afterburner, ¿es por algún motivo?

- El overdrive del monitor, la función de dar más de los 60Hz, ¿alguien la ha probado?

- En cuanto al overclock, por lo que leo, conviene dejar el ventilador en auto, y subir al tope linkados el Power y la Temperatura, sin ser necesario tocar el voltaje, ¿no?. Además, vengo de unas GTX 580, no tenían Boost, por lo que no tengo muy claro si hay que tocar el offset o bien eso no hace falta tocarlo y con subir la velocidad básica es suficiente.

Gracias por anticipado.

P.D. Vaya puntuación salvaje, y que gusto da verse ahí, recuerdo cuando hace años metí una puntuación entre las diez primeras la ilusión que me hizo …....

Hola Pepillo.

Basicamente són los mismos.Los beta tienen algunas mejoras en juegos como sniper Elite.Yo te aconsejo los beta,són estables y no dán problemas.Aunque no viene ninguna mejora específica para TITAN.

Para hacer Ocs fuertes con mucho gasto energético,es decir,benchear,si es mejor en auto.Para jugar con OC 24/7 es mejor hacer un perfíl.La gráfica no es para nada caliente,lo que pasa que prima el silencio sobre la temp,lo único que has de hacer es un perfil un poco mas agrasivo para que por ejemplo,no pase de 70º.

El OC lo puedes seguir haciendo con el MSI,la última beta 3.0.6 creo,es diferente,y nunca vás a ver reflejado lo que tu has puesto en el OC.Eso por culpa del boost.Es decir,si subes +150MHZ,no se vá a sumar la velocidad de stock de la gráfica a esos +150MHZ como en la GTX 580.Sino que será variable,siempre menor,dependiendo de lo bueno que sea tu chip y el boost que lleve.Hay varias…las buenas llevan de stock 1006MHZ con Boost..otras,las pocas,996MHZ..y la smalas,yo tengo una,980MHZ..

En cuanto al Oc del monitor no lo he probado..el mio es un DELL de 30" y ese,no se traga nada..aparte que es muy caro para andarse con historias,y mientras se mantenga siempre,eso si,SIEMPRE,en 60 fps yo tengo bastante.

Un saldo y gracias.La verdad es que llevo varios años estando siempre en el HOF,incluso llegué a estar el primero...pero siempre se entretiene uno y le vale de algo con los partners..poco,porque yo no soy ni muchos menos un overcloker..pero te respetan,te conocen y ya te hablán de tu..jeje

-

Envidia tremenda, pero nada de sana. De la mala, mala ;D

Felicidades

-

Gracias por la info. Esto sigo sin entenderlo:

El OC lo puedes seguir haciendo con el MSI,la última beta 3.0.6 creo,es diferente,y nunca vás a ver reflejado lo que tu has puesto en el OC.Eso por culpa del boost.Es decir,si subes +150MHZ,no se vá a sumar la velocidad de stock de la gráfica a esos +150MHZ como en la GTX 580.Sino que será variable,siempre menor,dependiendo de lo bueno que sea tu chip y el boost que lleve.Hay varias…las buenas llevan de stock 1006MHZ con Boost..otras,las pocas,996MHZ..y la smalas,yo tengo una,980MHZ..

Esos 150 de más, por ejemplo, ¿donde se ponen? ¿en el offset? ¿o eso es la diferencia entre el normal y el boost y no hay que tocarlo? En eso estoy muy verde, aunque supongo que cuando me llegue no será tan difícil como me parece ahora.

Saludos

-

Enhorabuena Elp3,…felicidades

saludos

-

Gracias por la info. Esto sigo sin entenderlo:

Esos 150 de más, por ejemplo, ¿donde se ponen? ¿en el offset? ¿o eso es la diferencia entre el normal y el boost y no hay que tocarlo? En eso estoy muy verde, aunque supongo que cuando me llegue no será tan difícil como me parece ahora.

Saludos

Si, donde debes subir el core se llama creo GPU clock offset,la memoria creo se llama Men clock offset,no creo que sea complicado pues al final parece que hace lo que quiere la tarjeta,osea que si metes +100 lo mismo no te aplica eso,por eso si monitorizas el GPU clock podras ir viendo cuanto va metiendo en realidad.asi calculas cuanto debes poner al GPU clock offset.

En esta captura de ELP3 se ve que esta monitorizando las frecuencias,se ven dos a misma frecuencia y las otras a menos,influira un poco lo buena que salga la tarjeta.

Saludos

-

felicidades Elp3