@Wargreymon:

Yo creo que en esa review lo que más destaca es que la HD7970 GHz da bastante más rendimiento que la GTX680, pero sus gráficas de frametime son lamentables. La GTX690 y los SLIs de Kepler, en ese sentido, tienen un rendimiento sorprendente, apenas parece que sean configuraciones multiGPU, aunque hay casos donde en la Titan se nota que las latencias son mejores gracias a ser monoGPU, pero aun así, los resultados de las Kepler en multiGPU son muy buenos, todo lo contrario a los CF.

El caso de Hitman Absolution es casi de juzgado de guardia, es un juego donde sus "optimizaciones" para DX11 (no hay que olvidar que no deja de ser un port) sirven única y exclusivamente para que las gráficas AMD puedan estar algo por encima de las de nvidia, a base del uso masivo de ciertas técnicas 3D (además la mayoría en realidad ni siquiera son técnicas DX11 en sí), siendo un bastante mal (o bueno, depende de lo que se busque) representante de un juego "Gaming Evolved".

No puede ser que con todo a tope básicamente hasta las monogpu de AMD más potentes se ahoguen.

Dicho esto, este juego además parece tener también un tope (cap) en los fps que puede generar EN EL BENCHMARK, y no me extrañaría que se aplicara además sólo en las nvidia (XD). Parece que el tope no se aplica durante el juego, lo cual lo hace bastante sospechoso (¿pones un tope en el benchmark de un juego pero no en el juego en sí, que es donde puede tener sentido por temas de temporización y demás de los eventos del juego?). Si encuentro donde lo leí ya lo pondré por aquí, era en una review con sistemas multigpu y Titan por el medio, donde se encontraban con un tope de 90 fps, creo. Se extrañaron y preguntaron a la gente de nvidia si sabían algo del tema, y la contestación fue que en el juego la tasa de frames no estaba capada, que iba mucho más alto.

A AMD le está funcionando muy bien su plan Gaming Evolved, ya que muchos de los títulos que apoya llevan benchmarks que hacen que se conviertan en pruebas elegidas por muchos usuarios y reviews, por facilidad de uso, y el uso de ciertas técnicas que se pueden considerar en exceso (un ejemplo que he puesto más de una vez, es el uso ridículo de SSAA+MSAA+FXAA/MLAA, que se ha hecho en algún título, con por lo menos 2 de esos factores, y creo que había uno concreto que llegaba a usar las tres técnicas a la vez), pero que dichas técnicas "favorecen" a AMD de muy distintas formas.

En realidad si nos fijamos en los últimos Gaming Evolved podemos ver el patrón de benchmark interno más opciones salvajes de GI+HDAO+SSAA (y demás técnicas que AMD gusta de poner):

Sleeping Dogs.

Hitman Absolution.

Sniper Elite V2.

Dirt Showdown.

Etc.

Todos tienen benchmark Y combinan el uso de técnicas muy exigentes en ancho de banda y muy adaptadas a la arquitectura de GCN, tanto sea por la implementación de la técnica (GI, HDAO) como por la propia técnica en sí (SSAA).

Estos títulos suelen ser importantes, pero no son lo que realmente se llaman AAA, son ports en la mayoría de casos y las ventas en PC quizás no esperan ser demasiado altas (excepto con la propia ayuda del acuerdo de venta de gráficas con licencias del juego). Esto es, que su mercado principal son las consolas.

Si nos fijamos en los auténticos AAA, ese tipo de juego que es esperado desde hace tiempo, se comenta antes mucho, y que intentan mostrar las técnicas más modernas en rasterizado para PC, tenemos a dos auténticos peces gordos, AAA:

Far Cry 3.

Crysis 3.

Ambos juegos son indudablemente AAA, se habló mucho antes de su lanzamiento de cómo serían, qué novedades gráficas tendrías. ambos tienen una buena expectativa de ventas en todas las plataformas, pero lo más importante, tienen un pie muy sólido en el mercado del PC, donde su motor gráfico vió su nacimiento y plataforma donde se sigue afinando dicho motor.

Ninguno trae un benchmark integrado y curiosamente ambos rinden igual o ligeramente mejor en las nvidia que en las AMD.

O sea, que hay que tener mucho cuidado con las reviews cuando se cogen ciertas pruebas un tanto capciosas, o se rebalancea el setup con juegos igual de "descaradamente" pronvidia (siempre me viene a la cabeza el Lost Planet 2, pero en parte es injusto porque más allá de su uso de teselación muy a fondo, no se conoce de "intentos de boicoteo" a AMD y su rendimiento, que sus teseladores sean lentos no es culpa de CAPCOM), o se está haciendo mal. Porque después cuando juegues a otros juegos menos populares (porque no tienen audiencia o simplemente porque no tienen benchmark integrado) en reviews y demás, igual resulta que la imagen que te llevabas con esas reviews puede estar distorsionada (reviews de sites e usuarios y foros, ojo).

Yo es que cada vez que veo una prueba de Hitman o de Dirt Showdown me suelta un tufo tremendo sus resultados, son muy cantosos.

Que de todas formas, incluso a pesar de eso el tema de las latencias no lo lleva tan bien siquiera las AMD en "sus pruebas":

http://www.tomshardware.com/reviews/geforce-gtx-titan-performance-review,3442-6.html

Tomshardware tiene un sistema derivado pero suficientemente distinto de medir latencias (la oleada que ha creado en sites de reviews TechReport, por cierto, y "ninguneada" por mucha gente por incómodos resultados), donde en vez de medir las latencias y buscar sólo las latencias "altas" por considerarlas las problemáticas (es acertado en este punto), hace otra cosa distinta:

Mide la diferencia entre latencias de frames consecutivos, y a través de este valor y con métodos estadísticos (uso de percentiles) comprueba si son buenas o no las latencias.

Creo que ellos mismos no tienen afinado el sistema, por varias razones:

El uso de percentiles como el 75º percentil no tiene demasiado sentido, porque al hablar de frames y sus latencias esto quiere decir que busca la latencia de "corte" que define a las latencias más altas de ese valor que ocurre en 1/4 de los frames totales.

Esto es, que si tienes 60 fps por imagen posiblemente estás hablando de hacer una criba y selección de los 15 fps más lentos en ese segundo (no es exactamente eso, pero para simplificar lo dejo así). Son demasiados frames, es cierto que es un valor que puede tener algo de sentido, pero no debería estar demasiado lejos de la media, y sobre todo, no cazaría los problemas de latencia, donde no hace falta que sean tantos frames por segundo los registrados, sino que se cacen los frames más molestos.

el 95º percentil tiene algo más de sentido, pero de todas formas es un percentil muy generoso, ya que aún así muestrea 1/20 del total de frames renderizados cogiendo los más "lentos" (corte a partir del cual éstos aparecen), o sea, que puede tocar perfectamente a varios frames por segundo.

Yo abogo tanto por el uso del 99º percentil así como percentiles incluso más altos como el 99,5 percentil y similares, porque si estás jugando y cada 3-4 segundos tienes un pequeño parón por culpa de un frame de 60 ms (posiblemente no rompe del "todo" la ilusión de animación, pero está al borde de ser directamente stuttering), la experiencia es horrible, y percentiles más bajos pueden no decir nada sobre el tema.

Bueno, aún a pesar de todo este rollo, en esa review de Toms y con los datos que ellos consiguen, se ve que Hitman no va del todo fino en el hard de AMD, porque tiene una latencia de más de 10 ms en una resolución muy normalita (1080p) y ya en 1600p la cosa se dispara por encima de 20 ms.

Yo a estas latencias las consideraría muy peligrosas, y creo que en esto en Toms aún no tienen pulido su metodología nueva no ya por el tema de percentiles usados, sino porque lo que ellos miden son las diferencias entre latencias consecutivas (que creo que es un buen método para cazar el principal problema de los sistemas multigpu, cuándo se vuelve molesto).

Y por tanto, al ser una diferencia de latencia, aunque ellos puedan considerarlas "bajas" no lo son tanto, porque para ir a 60 fps necesitas latencias por frame de 16,6 ms, así que si tienes una diferencia de latencia entre frames de 10 ms, excepto que estemos hablando de generar frames en 2-3 ms, que va a ser que no, realmente estarás metiendo frames intermedios (diferencia de latencias) por debajo de esos 60 fps. O incluso mucho peor.

Una extrapolación no del todo correcta, en el caso de Hitman sería interpretar los fps medios y añadirle el 95 percentil en forma de latencia:

Con la 7970: 67 fps-> 14,9 ms. –> latencia media + dif. latencia 95º percentil = 14,9 ms + 11,1 fps = 26 ms. --> fps "aproximados" 95º percentil = 38,5 fps.

O sea, un valor bastante "bajo" de fps puntuales en algunos frames. He de decir que este cálculo aproximado es positivo para el resultado de la 7970, ya que en la realidad apostaría a que esas diferencias de latencias del 95º percentil se encuentran entre frames que se generan en las zonas del bench más lentas en rendimiento. O sea, que en realidad se está haciendo un favor con este cálculo con los fps medios.

Ya el tema de los 20 ms de diferencia de latencias consecutivas, vamos, eso es que tiene que ser malo para la jugabilidad sí o sí.:ugly:

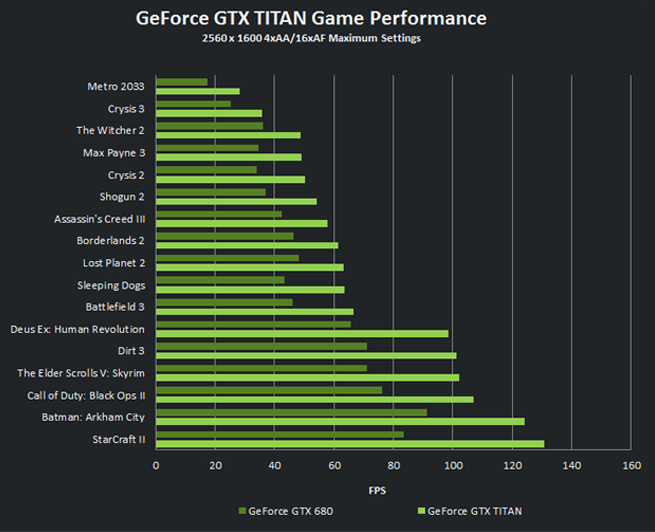

Este problema de latencias consecutivas dispares se ve que aparece bastante en la 7970 GHz aún siendo una monogpu, y que por ejemplo la Titan no lo tiene apenas frente a la GTX 690. Lo cual apunta a una de las ventajas principales de la Titan. Rendirá algo menos, pero de forma más sólida. Señalar que la Titan parece que necesita pulido de drivers, porque a veces tiene algún mínimo o latencias más altas que su "inferior" hermana, la GTX 680. Lo cual apunta a que se podrá optimizar casi seguro su rendimiento en breve, que los drivers actuales para Titan aún están un poco verdes en afinar sus diferencias con respecto a las otras Kepler.

y un sli de Titanes debe tirar mas que mi trio, no se cuanto, pero deberia sacarle ventaja.

)