Vaya ELP3, veo que al final no has podido resistirte y has acabado probando esas GPUs que tanto nos han dado que hablar. Parece que se confirman las sospechas que me comentaste sobre el consumo y su consecuente temperatura, vaya tela.

Saludos ;).

Vaya ELP3, veo que al final no has podido resistirte y has acabado probando esas GPUs que tanto nos han dado que hablar. Parece que se confirman las sospechas que me comentaste sobre el consumo y su consecuente temperatura, vaya tela.

Saludos ;).

25º C menos se ve muy interesante, aunque prefiero que expulse la gpu aire hacia afuera de la torre

Mi titan se mantiene en 80º con cooler fan speed a 78%

En los últimos días estoy rondando a cambio de gabinete de Thermaltake Element S a Cooler Master HAF XM, la diferencia seria tener 1 cooler lateral de 200mm y añadiría 2 cooler de 120mm en el anclaje de los HDD para que le de aire de frente a la Titan.

Lograra bajar las temperaturas a menos de 70º C y por ende también el fan speed a menos de 70?

Que opináis ?

No estaría yo muy seguro, yo creo que para mantener estas GPUs a buenas temps lo mejor es meterle un Accelero Xtreme III de esos aunque el calor se quede dentro de la caja, que yo compré el modelo de referencia precisamente por que sacaba el aire fuera y tal pero no le veo la ventaja si no es con un SLI.

Saludos.

Hazle un perfil de ventilador para que se acelere antes, no entiendo por que Nvidia mete ese boost y al final se necesita flasear las tarjetas para poder hacer cosas como OC o perfiles de ventilador mejores, si lo aceleras antes no creo que ni te haga falta 60% de revoluciones, lo malo de todos los perfiles Nvidia es que se acelera muy tarde y luego necesita mas revoluciones, si se acelera al pasar de 50º dudo que necesite muchas revoluciones y se calentara menos.

Pero para ocear parece que hay que cambiar bios a la Titan a la 780 y a la 770, por que sino limitan bastante el OC.

saludos

Tengo creado un perfil, pero no puedo mantener la GPU por debajo de 70ºC con el ventilador entre el 60 y el 65%. Bueno, puedo si aumento la velocidad de los ventiladores de la caja, pero no sale muy rentable por el ruido.

pues vaya, entonces es tirando a calentorra por lo visto, lo decia porque en otros foros hay gente que la tiene y dicen que al 60-65% no hace nada de ruido y no pasa de 70 grados, y sin vsync, con vsync supuestamente serian menos de 70º.

wargreymon la tienes oceada o de stock? porque si la tienes a stock con el fan al 65% no te deberia de pasar de unos 63-65 grados, con vsync activado mayormente…

Las pruebas las he hecho de stock, Ocar se Ocea ella sola, ya sabes que no todas son iguales con el tema del boost. Dependerá de cuanto la machaques, el crysis 3 la machaca mucho, he pasado el valley por ejemplo y no ha pasado de 75ºC, pero a mi al menos a menos de 70º no se me mantiene ni de coña dejando el ventilador fijo a esas velocidades.

alguno de vosotros tiene una 780 modelo de referencia? sin ningun oc y con el fan al 60% mas o menos que temperaturas teneis? , y el fan al 60 o 65% hace mucho ruido?

Yo tengo el modelo de referencia, al 60-65% mucho mucho ruido no hace pero si que se nota bastante que está girando más rápido, y a partir del 70% ya es bastante ruidoso.

He probado a jugar un poco al crysis 3 con el ventilador fijo al 65% y en 10 minutos o así la temperatura llega a los 80ºC y salta el thermal throttle. Igual en otra caja no ocurre, yo tengo una Silverstone Raven 03.

Parece que los rumores cambian cada día, por que segun esta tabla la GTX780 tendría un bus de 384 bits, faltaría saber que le recortan al chip:

Link:http://videocardz.com/41336/nvidia-geforce-gtx-780-features-gk110-300-gpu

AMD confirmó que su nueva generación de tarjetas gráficas, las AMD Radeon HD 8000 Series, no van a llegar en los próximos meses, y su llegada se espera para finales de año, como mínimo.

Después de conocer que AMD no va a lanzar su nueva generación de gráfica próximamente, ahora nos llega una nueva información que sitúa el lanzamiento de la Serie GeForce 700 de Nvidia en el año 2014.Hay que aclarar que las GTX Titan no pertenecen a la nueva serie 700 de Nvidia, algunas informaciones se refieren a estas gráficas como GeForce GTX 780, pero hay que aclarar que ninguna de ellas es la GTX 780.

Nvidia GeForce 700 Series: Retrasadas hasta el año 2014

[Rumor] NVIDIA Delays GeForce 700 Series Till 2014 - GeForce GTX Titan LE in Q3 2013

saludos

Esos rumores son más antiguos que estos ;D. Quien sabe, eso si, las Maxwell que yo sepa siguen programadas para el año que viene, pero si sacan una serie completa ahora no creo que saquen Maxwell hasta, por lo menos, un año después que las GeForce GTX700, por que si que han dicho alguna vez que los 20nm no les aportan lo que quieren. Así que quizás dejan a AMD que saque sus volcanic islands en el "estreno" de los 20nm, y nVidia saque Maxwell cuando el proceso esté más pulido y con precios razonables.

Bueno, yo ya te he felicitado pero lo hago otra vez, ¡¡FELICIDADESS!!

¡Felicidaes con retraso neptunillo! Que lo pases bien y lo disfrutes con los tuyos ;).

Aaanda que todo son problemas! :ugly: jajaja.

Codificando video no haces varios a la vez, simplemente tienes un montón de datos (cuadros, macro bloques, etc.) que se pueden repartir, sí no es complicado de dividir pero igual que pasa con la mayoría de las tareas de más consumo para la CPU. Y los benchs marcan FPS al codificar un video. Verás que los mejores resultados son de los Intel de 6 núcleos, 4+HT, 4, y en 2nd pass los FX-8 en segundo lugar.

Bueno, eso depende de lo que hagas. Yo lo de comprimir un video con cada núcleo lo ví con un programa (No recuerdo cual) que usaba para recomprimir los videos a un formato compatible con el iPhone que tenía, y por defecto el programa hacía eso, si te detectaba una CPU de 2 hilos y una cola de 4 videos pues comprimía 2, uno en cada hilo, y después los otros dos, si te detectaba 4 cores pues los 4 a la vez… Así sucesivamente. Otro asunto es la pasar un video de un formato a otro por ejemplo y cosas así.

Por lo demás que comentas estoy bastante de acuerdo contigo, si todos los juegos pudieran emplear los 8 núcleos de Bulldozer otro gallo cantaría (Lo mismo yo tendría uno, no tengo inconveninete, de hecho, tengo un piledriver de 4 cores en el HTPC). Y el mercado actual está bastante segmentado en el tema que comentas de ipc vs núcleos, que como dices eso sería lo discutible, el problema es que practicamente, con un precio normal, solo puedes elegir o una CPU con muchos núcleos y poco ipc o una CPU con mucho ipc y pocos núcleos. Si quieres algo intermedio, que el único que se me ocurre es el 3930K toca pagar 500 eurazos, y claro...

Si, como dices esos juegos emplean muy bien el multihilo, desde luego no lo niego, el crysis 3 ya lo había mencionado por ahí arriba y sí, la verdad es que sabe emplear muy bien la CPU, incluso parece capaz de poner en aprietos los 4 núcleos de un Sandy pero de momento es una excepción. Seguramente en el futuro esta sea la tendencia, pero para cuando llegue ese momento seguramente tengamos CPUs de 6/8 núcleos con ipc decente a mejor precio que a día de hoy. A día de hoy de momento me quedo con Sandy/Ivy y los futuros Haswell.

Dije programando para y en el mejor de los casos sino suele rendir a par o menos que un 2500, no vamos a discutir cosa obvias por favor, pero como dices ese diseño "en bloques" quizás no sea el principal problema.

Hay pocas tareas que tengan un gran consumo de CPU pero las que lo hacen: compresión de archivos, modelado 3D, encriptacion, calcuos en excel, juegos, suelen aprovechar el paralelismo; comparando ahora un dual vs. quad no van a empatar (HT aparte). Deja a los programadores tranquilos, si es lo que hay no volveremos a procesadores mono hilo, el mayor problema es que no se puede programar para X hilos tiene que ser flexible porque hay variedad de CPUs (con 2, 3, 4, 6, 8 y 12 hilos). Siempre habrá tareas que aprovechen más y otras menos…

Dos tareas de rendimiento puro y duro que creo que reflejan bien lo que cada CPU puede rendir en bruto aprovechando todos los núcleos:

!

@__wwwendigo__ en ningún momento he dicho que me parezca mejor o buena la arquitectura de bulldozer, solo he dicho que me parece interesante o explotable el diseño en bloque. Pero se nota que a ti si que te gusta porque lo discutes con ansias

El problema está en que no es lo mismo paralelizar un juego que paralelizar un programa de codificación de vídeo por ejemplo. En un programa de codificación de vídeos, si tienes que comprimir por ejemplo 8 vídeos de X longitud siempre puedes comprimir cada uno de ellos usando un núcleo (O coger un vídeo largo y que cada núcleo procese una parte temporal), eso es un buen ejemplo de una aplicación fácilmente paralelizable.

El problema de los juegos es que esa división no se hace así (Salvo que juegues a 8 juegos a la vez y quieras que cada uno te use 1 o 2 hilos :ugly:), la mayoría de juegos suelen dividir los subprocesos de forma que cada núcleo procesa algo más o menos independiente; Un núcleo para la IA, otro para el sonido, otro para físicas…

El problema de eso es claro, que no requiere la misma capacidad computacional la IA que el sonido por ejemplo, así que de alguna forma el problema es que tienes un claro desequilibrio en cuanto al empleo del multihilo. Por cosas así no veo la ventaja a los Bulldozer en su estado actual, por que se suelen dar casos en juegos donde un núcleo tiene mucha carga y otro tiene una carga muy baja, y por lo tanto, contra más potente sea el núcleo que tiene la mayor carga, mucho mejor, de otra forma te va a limitar completamente el rendimiento, por eso me empeño tanto en el tema del ipc, por que el problema no es solo la programación multihilo en sí, sino conseguir un equilibrio entre todos los hilos/núcleos usados para que no haya 1 o 2 núcleos, completamente saturados al 100% de capacidad, mientras los otros 6 están uno al 5%, otro al 10% , otro al 30% y el resto al 25%. Surge un claro desequilibrio en el rendimiento multihilo que no vas a tener si codificas un vídeo en cada núcleo, por que en ese caso vas a tener una carga multihilo equilibrada donde todos los núcleos van a ir al máximo.

La conclusión de todo esto es que sí, en el ejemplo que pones se observa que con más núcleos se obtiene mayor rendimiento (Esto es una de esas cosas obvias que nadie está discutiendo, haciendo mías tus palabras) pero es muy dependiente de la aplicación, y esto siempre, una aplicación de render y una aplicación de compresión en .zip realizan cálculos completamente diferentes dentro de la CPU, y eso hay que tenerlo en cuenta por que para una CPU no es lo mismo una suma, que una división con decimales o una multiplicación vectorial, son operaciones distintas que condicionan el comportamiento interno de la CPU, y en ese sentido surgen importantes diferencias a la hora de comparar las diferentes arquitecturas (Vease el escaso rendimiento de los Bulldozer/Piledriver con instrucciones AVX).

Se me había pasado… no me explique bien, lo que quería decir era que es importante distribuir entre las unidades de ejecución.

En bulldozer se juntan dos unidades de ejecución, cada una con 2x ALU/AGU, el total es superior al de un Sandy que tiene 3x ALUs y 2x AGU. El caso es que lo que realmente es un núcleo pero funciona como dos a nivel de ejecución, el problema si no hay un soft optimizado no funciona bien y en la practica es bastante inútil, aunque en teoría el potencial es bueno* en el mejor de los casos. Si se mejorase cosas como el ancho del decoder, o igual redistribuyendo los caches puede que funcionase mejor sin tener que programar específicamente.

PD. @__wwwendigo__ estoy exagerando :ugly: evidentemente han evolucionado muchísimo, pero ninguna idea revolucionaria (aparte del HT, a mi parecer) simplemente han seguido una progresión fantástica. Las gráficas dieron un salto importante desde las 900 que no eran ni gráficas pero aun siguen siendo una cagarruta. Y si por supuesto que no creo que veamos CPUs con 40 o 80 núcleos, pero 8, 16 porque no?, la sincro solo la tienes asegurada si procesas una cosa detrás de la otra lógicamente; pero aparte del sector profesional es ahora cuando se hacen aplicaciones pensadas para funcionar en varios núcleos, no es que vayamos a saltar a ninguna parte solamente que los que no lo han hecho lo acabarán haciendo.

Ese ejemplo que me pones representa el uso de instrucciones XOP, de las cuales los Sandy/Ivy carecen… Aun así no deja de ser curioso ver al Pehnom II x6 tan alto, practicamente a la par del FX8350 con sus 8 núcleos y eso funcionando este último a mayores frecuencias claro.

La arquitectura Bulldozer tiene más pegas que su diseño de bloques, con cachés L1 pequeñas y lentas, y cachés L2 y L3 bastante lentas también, por no hablar del controlador de memoria que no a avanzado apenas desde los K8.

No se trata de defender el ipc de los 4 núcleos "por que sí", la defensa viene sencillamente de las decisiones de los programadores en cuanto a multihilo y la complejidad de programar así, que se hará, eso seguro, pero pueden pasar muchos años hasta ver aplicaciones empleando 6/8 hilos de forma general, y diciendo muchos quiero decir muchisimos, que actualmente los quad-cores están bastante infrautilizados, y los dual-core a veces también por que son un millar las aplicaciones que aun a día de hoy solo tiran de 1 hilo, la gran mayoría (Dejando de lado los juegos que parece que son incluso los que más partido sacan). Y a tu review me remito:

Que sí, que empleando 8 hilos no ocurriría esto, pero eso diselo a los programadores, hasta entonces la carrera de núcleos para uso doméstico no tiene mucho sentido.

Parece que será AMD quien acabe sacando más núcleos, a Intel aun no le hace falta :troll:

Un buen ejemplo son los ARM que no me estañaría que acabasen saltando al mundo de los portátiles, los X86 actuales son bastante complicados e innecesarios para muchas tareas ligeras, lo ideal es un buen equilibrio entre IPC y paralelismo. Con un soft bien preparado sería como pensar hoy en comprar un mono núcleo sin HT, por muy potente que sea, no sería una buena idea.

¿ARM más fácil que x86?, si existe desde los años 70, arquitectura más conocida y familiar que esta dificil…

De poco sirve que las CPUs de AMD tengan más núcleos si incluso con todos en uso, como mucho, igualan a un i7 de la competencia, y con pocos hilos directamente la competencia los humilla.

Sinceramente, me extrañaría bastante que AMD sacara CPUs con más de 8 núcleos a corto plazo, sacar un Bulldozer con 10 o 12 núcleos no les iba a servir para nada más que hacer chips más caros y con el mismo rendimiento. Viendo los cambios que están haciendo en steamroller, que afortunadamente son cambios hacia adelante salvo fracaso de última hora, más bien se están centrando en tratar las debilidades de la arquitectura en lugar de en mantenerla y seguir metiendo núcleos a lo bestia.

@__Wargreymon__ no estoy hablando de nada que no exista, simplemente que con el tiempo se explotará mejor lo que ya hay, la mejor formula quien sabe. Pero estoy seguro que a corto plazo (5 años) seguiremos añadiendo núcleos porque la mejora de potencia bruta por ciclo va a seguir avanzando como siempre. Incluso parece a veces más rentable tener varios núcleos más simples o con menos ALU/FPU que uno con muchas, sobre todo para tareas simples, a quien el importa que te tarde 1" menos en descomprimir un ZIP si el procesador te cuesta un 50% más (por exagerar el tema).

Eso está claro, llegará el día en que Intel nos saque 6/8 núcleos en el segmento performance, pero no estoy de acuerdo en que sea más rentable tener núcleos más simples pero en mayor cantidad sobre núcleos más potentes y en menor cantidad, la mejor apuesta sigue siendo el mayor rendimiento por ciclo posible, y después de eso ya el número de núcleos (Salvo que hablemos de diferencias muy pequeñas en cuanto a ipc entre una CPU de 2 núcleos y otra de 4 claro).

Lo que hace el CryEngine 3 en el Crysis 3 con la CPU por ejemplo es muy interesante por que parece ser capaz de emplear todos los hilos que tenga una CPU (Creo que el tope son 12 hilos) para evitar cosas como las que ocurren en el Tomb Raider o en el crysis original que también tenía (Y tiene) ese problema de dependencia de CPU siendo capaz de usar pocos núcleos, así que acaba saturandolos y limitan el rendimiento.

PD2. Y no quiero decir que una operación se pueda realizar en dos núcleos a la vez que sería imposible, pero sabemos que al ejecutar varias operaciones en un hilo nunca va ser 100% eficiente a menos que sea un calculo puro y duro, el HT lo que hace es rellenar los huecos que quedan en la ejecución. Lo que yo digo es que si la cola (fetch, predictor, decoder) pudiera distribuir más eficientemente las operaciones en vez de en un FPU/ALU en varios mejoraría el rendimiento.

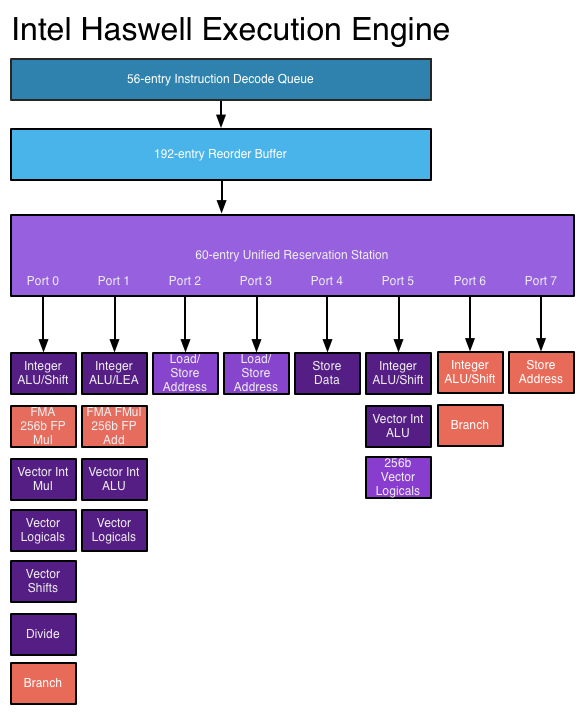

Es que, como te comenta wwwendigo, las unidades de ejecución de un núcleo no tienen una ALU, sino varias (4 ALUs por core en Haswell, 3 ALUs por core en Sandy/Ivy/Nehalem/Core y 2 ALUs por core en los Bulldozer).

Sobre papel, en Haswell podrías enviar desde los schedulers en un ciclo 4 uops a las ALUs, es decir, estarías empleando 4 ALUs a la vez (Y ocupando los puertos 0,1,5 y 6), más las operaciones de memoria de los puertos restantes que serían otras 4 uops, es decir, 8 uops en total, una por cada puerto de los que dispone Haswelll (En Bulldozer serían 4 uops en total, 2 de computación y 2 de memoria). Por lo tanto, eso que comentas es precisamente lo que ya se hace.

Conseguir que un único hilo se ejecute en varios cores es actualmente impensable, muy complejo y con bastantes pegas.

Falta ver la mejora en juegos con GPU dedicada y la prueba de la caché L2 es extraña, por que debería doblar a la generación anterior. Quizás la versión final rinda más de lo que se observa ahí…

En cuanto a GPU falta por ver la GT3, pero si la GT2 rinde así, la GT3 me da que se va a fundir a las APUs de AMD en el mercado de los portatiles.

Ya..bueno,es que esa gráfica y lo de los 2Gb es de juzgado de guardia..pero bueno..aparte de eso,te ha gustado?

Un saludo.

Dejando eso de lado sí que me ha gustado sí, tampoco es un supercambio respecto a la HD6950 pero si que va bastante mejor en casi todos los juegos, sobretodo hablando de MS, en este sentido pasandole la mano por la cara también a la HD7950 que tuve.

Me la compré pensando en poner otra en SLI en caso de que funcionara bien en el Skyrim con MODs, y bueno, con los MODs antiguos si que iba bien, pero al ponerle unos cuantos nuevos la pobre se ha rendido ;).

Wargreymon, no seas falso y contesta a ELP3 qué te ha parecido la pequeñaja, que bien sabes que no te ha dejado ni descontento ni le has puesto sólo 4 MODs, jajaja (que mira que eres bestia con los MODs).

Ya sabes que excepto que se apure mucho la VRAM de la gráfica (al límite al límite), el tema no parecía irte "tan mal". Más si comparamos cifras con tarjetas más capaces (y con más VRAM que llenar de todas formas).

Jaja pues si, el Skyrim con MODs es el único juego donde he visto el "problemilla" de los 2Gb, el Far Cry 3 por ejemplo va muy bien y en general todos los que no lleguen a 1,5-1,6Gb van muy bien. Para quien no vaya a jugar al Skyrim (O lo vaya a jugar con pocos MODs) me parece una gran GPU a buen precio, más fiable que las de la competencia de este rango de precios la verdad y sin los problemas de MS tan característicos…

Respecto al vantage no me había fijado en esa opción, me habrá pasado como a Pepillo seguramente si...

Saludos

A mi si me funcionan las físicas,acabo de jugar a Alice Madnes y se nota un monton y eso no lo hace la CPU por que se atrancaria,asignala manualmente a la GPU, yo con la 470 juego a Alice Madnes con physx alto y se nota bastante,hice una zona submarina que tiene mucho physx y mucho Ápex y lo hace la GPU,se puede ver el indicador poniéndolo en el driver a ver si funciona physx es como la barra SLI pero para PhysX,si funciona te sale y sino pues no sale.

Jotole esas Titan quedan muy bien en tu equipo, no parece que necesiten la RL.

saludos

No es que no funcionen las físicas, hablamos solo de la prueba de físicas del vantage, no de los juegos que usan Physx ;).